Integrationen af generativ kunstig intelligens i virksomhedens arbejdsgange er ikke en fremtidsorienteret idé; det sker lige nu, i et tempo, der ofte overgår sikkerheds- og styringskapaciteter. For hver dokumenteret, godkendt brug af et kunstig intelligens-værktøj, der øger produktiviteten, er der utallige tilfælde af "skygge"-brug, der udsætter organisationer for betydelige trusler. Udfordringen for sikkerhedsanalytikere, CISO'er og IT-ledere er klar: hvordan muliggør vi den innovation, kunstig intelligens lover, uden at invitere til uacceptable risici? Svaret ligger i en disciplineret, proaktiv tilgang til AI-risikostyring. Det handler ikke om at blokere fremskridt; det handler om at bygge rækværk, der giver din organisation mulighed for at accelerere sikkert.

Den voksende nødvendighed af AI-styring

Før en effektiv risikostrategi kan implementeres, skal der etableres et fundament for AI-styring. Den hurtige, decentraliserede implementering af AI-værktøjer betyder, at organisationer uden en formel styringsstruktur opererer i mørket. Medarbejdere, der er ivrige efter at forbedre deres effektivitet, vil uafhængigt implementere forskellige AI-platforme og plugins, ofte uden at overveje sikkerhedsmæssige konsekvenser. Dette skaber et komplekst netværk af usanktioneret SaaS-brug, hvor følsomme virksomhedsdata; fra PII og økonomiske optegnelser til intellektuel ejendom; utilsigtet kan blive overført til tredjeparts store sprogmodeller (LLM'er).

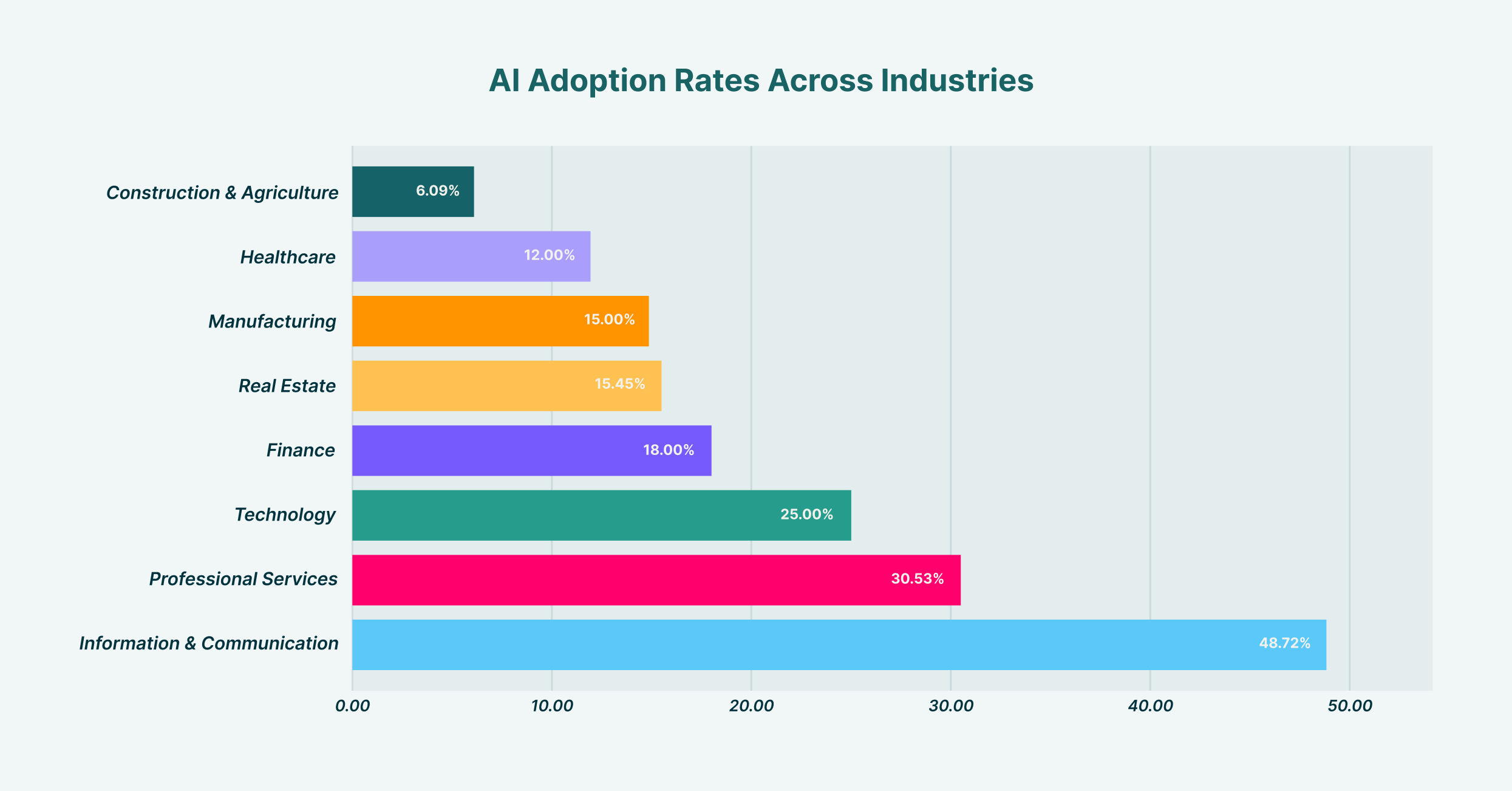

Adoptionen af AI varierer betydeligt på tværs af brancher, hvor Information & Kommunikation fører med 48.7% og Byggeri & Landbrug lavest med 6.1%.

Etablering af robust AI-styring indebærer at oprette et tværfunktionelt team, typisk bestående af repræsentanter fra IT-, sikkerheds-, juridiske og forretningsafdelinger. Dette udvalg har til opgave at definere organisationens holdning til AI. Hvad er vores risikoappetit? Hvilke use cases opfordres, og hvilke er forbudte? Hvem er ansvarlig, når en AI-relateret hændelse indtræffer? Besvarelse af disse spørgsmål giver den klarhed, der er nødvendig for at opbygge politikker og kontroller. Uden denne top-down strategiske retning bliver ethvert forsøg på at håndtere risiko en række usammenhængende, reaktive foranstaltninger snarere end et sammenhængende forsvar. Denne styringsramme bliver skabelonen for alle efterfølgende sikkerhedsindsatser og sikrer, at teknologi, politik og brugeradfærd er i overensstemmelse.

Opbygning af din AI-risikostyringsramme

Med en styringsstruktur på plads er næste skridt at konstruere en formel ramme for risikostyring inden for AI. Denne ramme operationaliserer jeres styringsprincipper og omdanner overordnet strategi til konkrete, gentagelige processer. Den giver en struktureret metode til at identificere, vurdere, afbøde og overvåge AI-relaterede risici på tværs af organisationen. I stedet for at genopfinde hjulet kan organisationer tilpasse etablerede modeller, såsom NIST AI Risk Management Framework, til at passe til deres specifikke operationelle kontekst og trusselslandskab.

Udviklingen af en effektiv ramme for risikostyring inden for AI bør være en metodisk proces. Den begynder med at oprette en omfattende oversigt over alle AI-systemer i brug; både godkendte og ikke-godkendte. Denne indledende opdagelsesfase er kritisk; du kan ikke beskytte det, du ikke kan se. Efter opdagelsen bør rammen skitsere procedurer for risikovurdering, tildele point baseret på faktorer som den type data, der behandles, modellens muligheder og dens integration med andre kritiske systemer. Afbødende strategier udformes derefter baseret på denne vurdering, lige fra tekniske kontroller og brugeruddannelse til fuldstændigt forbud mod højrisikoapplikationer. Endelig skal rammen indeholde en kadenc for løbende overvågning og gennemgang, fordi både AI-økosystemet og din organisations brug af det konstant vil udvikle sig. Der findes forskellige rammer for risikostyring inden for AI, men de mest succesfulde er dem, der ikke er statiske dokumenter, men levende, åndende komponenter i organisationens sikkerhedsprogram.

Kategorisering af AI-risici: Fra dataudvinding til modelforgiftning

En kernekomponent i AI og risikostyring er at forstå de specifikke typer trusler, du står over for. Risiciene er ikke monolitiske; de spænder over et spektrum fra brud på databeskyttelsen til sofistikerede angreb mod selve AI-modellerne. En af de mest umiddelbare og almindelige trusler er datalækage. Forestil dig en marketinganalytiker, der indsætter en liste over værdifulde leads, komplet med kontaktoplysninger, i et offentligt GenAI-værktøj for at udarbejde personlige e-mails. I det øjeblik er følsomme kundedata blevet exfiltreret og er nu en del af LLM'ens træningsdata, uden for din organisations kontrol og i potentiel overtrædelse af databeskyttelsesregler som GDPR eller CCPA.

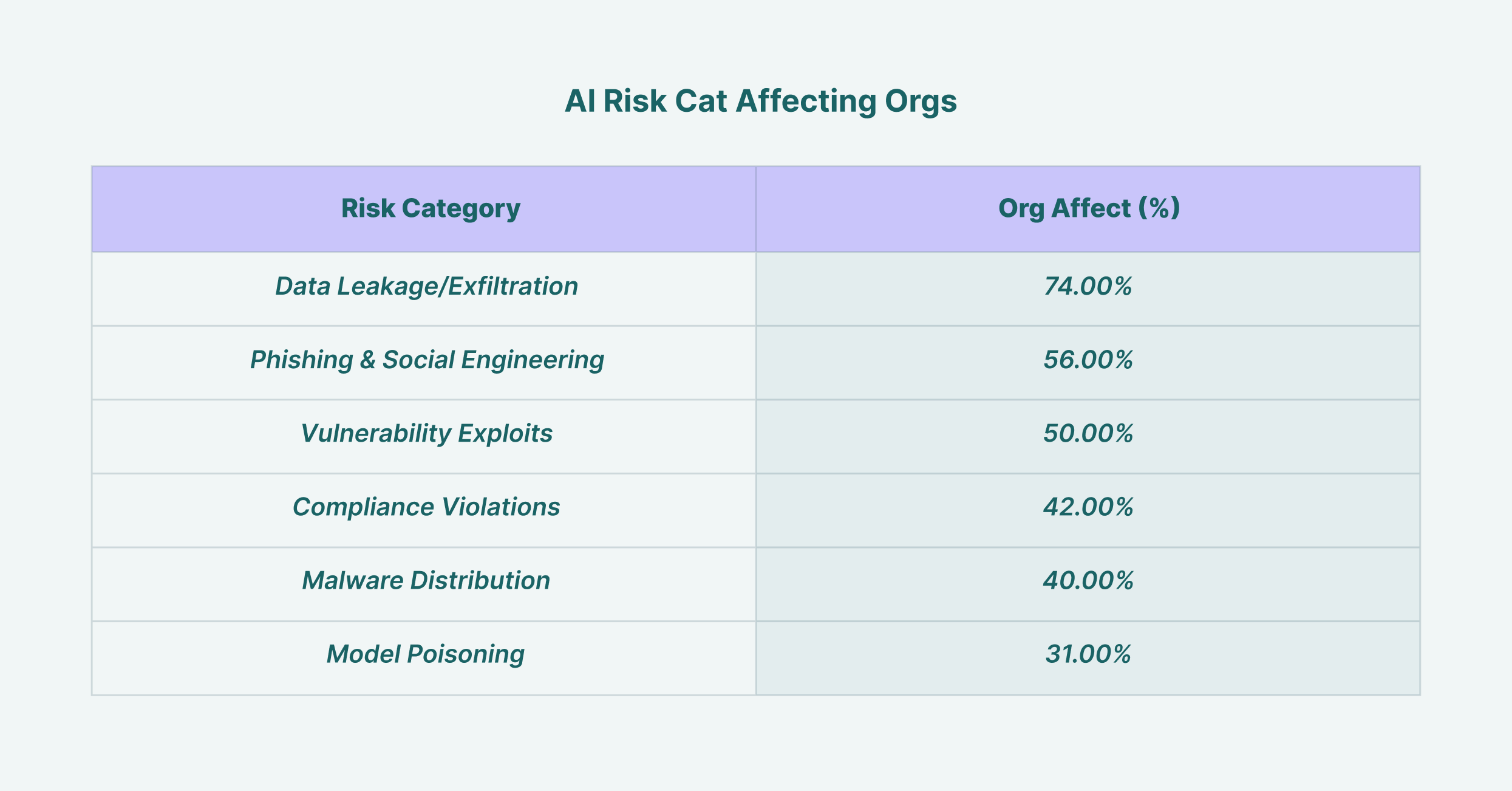

Datalækage påvirker 74% af organisationer, hvilket gør det til den mest udbredte AI-sikkerhedsrisiko, efterfulgt af phishing-angreb med 56%

Ud over datalækage skal sikkerhedsledere kæmpe med mere avancerede trusler. Modelforgiftning opstår, når en angriber bevidst fodrer en model med ondsindede data under dens træningsfase, hvilket får den til at producere forudindtagede, ukorrekte eller skadelige output. Undvigelsesangreb involverer at fremstille input, der er specifikt designet til at omgå et AI-systems sikkerhedsfiltre. For CISO'er betyder effektiv brug af AI i risikostyring også at udnytte AI-drevne sikkerhedsværktøjer til at opdage netop disse trusler. Avancerede trusselsdetekteringssystemer kan analysere brugeradfærd og datastrømme for at identificere anomale aktiviteter, der indikerer en AI-relateret sikkerhedshændelse, hvilket gør teknologien fra en kilde til risiko til en komponent i løsningen.

Den afgørende rolle for en AI-sikkerhedspolitik

For at omsætte jeres rammer til klare direktiver for jeres medarbejdere er en dedikeret AI-sikkerhedspolitik ufravigelig. Dette dokument fungerer som den autoritative kilde til acceptabel brug af AI i organisationen. Det skal være klart, præcist og let tilgængeligt for alle medarbejdere og ikke efterlade plads til tvetydighed. En veludformet AI-sikkerhedspolitik går ud over simple "dos and don'ts" og giver kontekst og forklarer hvorfor Visse restriktioner er på plads for at fremme en kultur af sikkerhedsbevidsthed snarere end blot overholdelse af regler.

Politikken skal eksplicit definere flere nøgleområder. For det første skal den liste alle sanktionerede og godkendte AI-værktøjer sammen med processen for at anmode om evaluering af et nyt værktøj. Dette forhindrer spredning af skygge-AI. For det andet skal den etablere klare retningslinjer for datahåndtering, der specificerer, hvilke typer virksomhedsoplysninger (f.eks. offentlige, interne, fortrolige, begrænsede) der kan bruges med hvilken kategori af AI-værktøjer. For eksempel kan det være acceptabelt at bruge et offentligt GenAI-værktøj til at opsummere offentligt tilgængelige nyhedsartikler, men det ville være strengt forbudt at bruge det til at analysere fortrolige økonomiske prognoser. Politikken bør også skitsere brugeransvar, konsekvenser for manglende overholdelse og protokollen for hændelsesrespons ved mistænkte AI-relaterede brud, så det sikres, at alle forstår deres rolle i at beskytte organisationen.

Evaluering af modeller og plugins: Fokus på AI-risikostyring fra tredjepart

Det moderne AI-økosystem er bygget på en kompleks forsyningskæde af modeller, platforme og plugins udviklet af tredjeparter. Denne realitet gør AI-risikostyring fra tredjepart til en kritisk søjle i din overordnede sikkerhedsstrategi. Hver gang en medarbejder aktiverer et nyt plugin til sin AI-assistent, eller dit udviklingsteam integrerer en tredjeparts-API, udvider de din organisations angrebsflade. Hver af disse eksterne komponenter bærer sit eget sæt potentielle sårbarheder, databeskyttelsespolitikker og sikkerhedstilstande, som nu nedarves af din organisation.

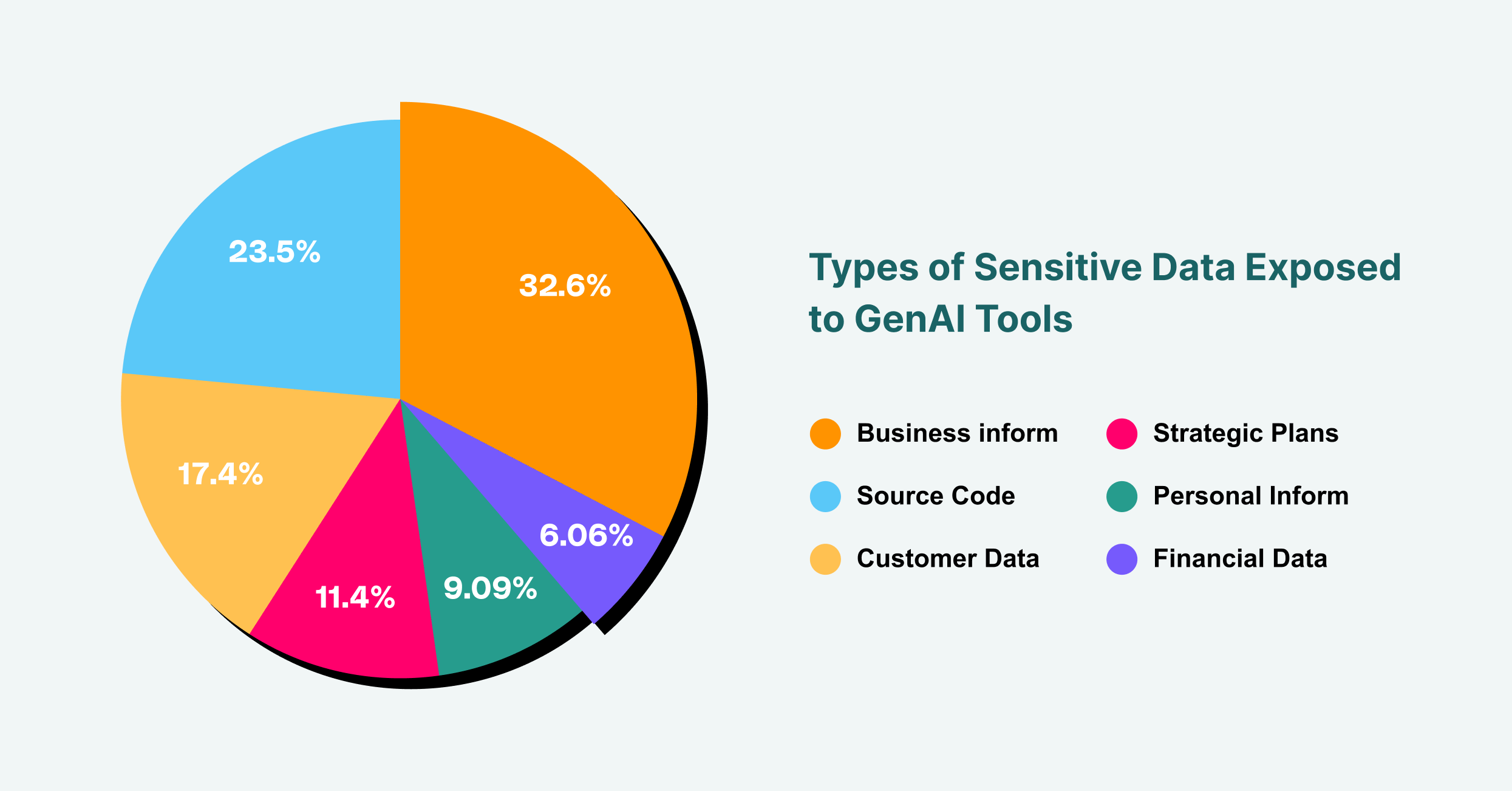

Forretningsoplysninger tegner sig for 43 % af følsomme dataeksponeringer til GenAI, efterfulgt af kildekode med 31 % og kundedata med 23 %

En grundig evalueringsproces er derfor afgørende. Før et tredjeparts AI-værktøj eller -komponent godkendes til brug, skal det underkastes en grundig sikkerheds- og privatlivsgennemgang. Dette involverer en granskning af leverandørens sikkerhedscertificeringer, datahåndteringspraksis og hændelsesresponskapaciteter. Hvilke data indsamler værktøjet? Hvor gemmes de, og hvem har adgang til dem? Har leverandøren en historik med sikkerhedsbrud? For AI-plugins, som er en voksende vektor for browserbaserede angreb, bør godkendelsesprocessen være endnu strengere. Spørgsmål, du kan stille, omfatter: Hvilke tilladelser kræver plugin'et? Hvem er udvikleren? Er dets kode blevet revideret? Ved at behandle alle tredjeparts AI-tjenester med samme niveau af granskning som enhver anden kritisk leverandør kan du mindske risikoen for, at et forsyningskædeangreb kompromitterer din organisation.

Implementering af AI-risikostyringsværktøjer

Politik og processer er grundlæggende, men de er utilstrækkelige uden teknisk håndhævelse. Det er her, AI-risikostyringsværktøjer bliver afgørende. Disse løsninger giver den synlighed og kontrol, der er nødvendig for at sikre, at din AI-sikkerhedspolitik følges i praksis, ikke kun i teorien. Da den primære grænseflade for de fleste brugere, der interagerer med GenAI, er webbrowseren, er værktøjer, der kan fungere på dette lag, unikt positioneret til at yde effektivt tilsyn.

Virksomhedsbrowserudvidelser eller -platforme, som LayerX, tilbyder en kraftfuld mekanisme til AI-risikostyring. De kan opdage og kortlægge al GenAI-brug på tværs af organisationen og give en realtidsoversigt over, hvilke brugere der tilgår hvilke platforme. Denne synlighed er det første skridt i at lukke skygge-AI ned. Derfra kan disse værktøjer håndhæve detaljerede, risikobaserede rækværk. For eksempel kan du konfigurere en politik, der forhindrer brugere i at indsætte tekst, der er identificeret som "fortrolig", i en offentlig AI-chatbot, eller som advarer brugere, før de uploader et følsomt dokument. Dette beskyttelseslag overvåger og styrer datastrømmen mellem brugerens browser og internettet og fungerer effektivt som en Data Loss Prevention (DLP)-løsning, der er skræddersyet til AI'ens tidsalder. De rigtige AI-risikostyringsværktøjer bygger bro mellem politik og virkelighed og giver de tekniske midler til at håndhæve dine styringsbeslutninger.

Hændelseshåndtering og -respons i AI-tidsalderen

Selv med de bedste forebyggende foranstaltninger kan der stadig forekomme hændelser. Hvordan din organisation reagerer er en afgørende faktor for at minimere virkningen af et brud. En effektiv hændelsesplan for AI skal være både specifik og velindøvet. Når en alarm udløses, hvad enten det er fra en brugerrapport eller en automatiseret detektion fra et af dine sikkerhedsværktøjer, har responsteamet brug for en klar strategi at følge.

Det første trin er inddæmning. Hvis en bruger utilsigtet har lækket følsomme data til en LLM, er den umiddelbare prioritet at tilbagekalde adgangen og forhindre yderligere eksponering. Dette kan indebære midlertidigt at deaktivere brugerens adgang til værktøjet eller endda isolere deres maskine fra netværket. Den næste fase er undersøgelse. Hvilke data blev lækket? Hvem var ansvarlig? Hvordan fejlede vores kontroller? Denne retsmedicinske analyse er afgørende for at forstå den grundlæggende årsag og forhindre en gentagelse. Endelig skal planen omfatte udryddelse og genopretning, hvilket omfatter at underrette berørte parter som krævet ved lov, tage skridt til at få dataene fjernet af AI-leverandøren, hvis det er muligt, og opdatere sikkerhedspolitikker og -kontroller baseret på de lærte erfaringer. En moden AI- og risikostyringsholdning betyder at være lige så forberedt på at reagere på en hændelse, som du er på at forhindre en.

Sporing og forbedring af din AI-risikoprofil

AI-risikostyring er ikke et engangsprojekt; det er en kontinuerlig cyklus af vurdering, afbødning og forbedring. Trusselsbilledet er dynamisk, med nye AI-værktøjer og angrebsvektorer, der konstant dukker op. Derfor er det vigtigt at spore din organisations AI-risikostilling over tid for at sikre, at dit forsvar forbliver effektivt. Dette kræver en forpligtelse til løbende overvågning og brug af metrikker til at kvantificere dit risikoniveau og dine kontroller.

Nøglepræstationsindikatorer (KPI'er) kan omfatte antallet af ikke-godkendte AI-værktøjer, der er blevet opdaget, mængden af forhindrede datalækagehændelser, og procentdelen af medarbejdere, der har gennemført AI-sikkerhedstræning. Regelmæssige revisioner og penetrationstest, specifikt fokuseret på AI-systemer, kan også give uvurderlig indsigt i svagheder i dit forsvar. Ved løbende at måle og forfine din tilgang skaber du et robust sikkerhedsprogram, der tilpasser sig de udviklende udfordringer i den AI-drevne verden. Denne proaktive holdning sikrer, at din organisation fortsat kan udnytte AI's kraft trygt og sikkert og omdanne en potentiel kilde til katastrofal risiko til en velforvaltet strategisk fordel.