De integratie van generatieve AI in bedrijfsworkflows is geen toekomstmuziek; het gebeurt nu, in een tempo dat vaak de mogelijkheden op het gebied van beveiliging en governance overtreft. Voor elk gedocumenteerd, goedgekeurd gebruik van een AI-tool die de productiviteit verhoogt, zijn er talloze gevallen van 'schaduwgebruik', waardoor organisaties worden blootgesteld aan aanzienlijke bedreigingen. De uitdaging voor beveiligingsanalisten, CISO's en IT-leiders is duidelijk: hoe kunnen we de innovatie die AI belooft waarmaken zonder onaanvaardbare risico's uit te lokken? Het antwoord ligt in een gedisciplineerde, proactieve aanpak van AI-risicomanagement. Het gaat er niet om de vooruitgang te blokkeren; het gaat erom maatregelen te nemen die uw organisatie in staat stellen veilig te versnellen.

De groeiende noodzaak van AI-bestuur

Voordat een effectieve risicostrategie kan worden geïmplementeerd, moet een basis voor AI-governance worden gelegd. De snelle, gedecentraliseerde adoptie van AI-tools betekent dat organisaties zonder een formele governancestructuur in het duister tasten. Medewerkers die hun efficiëntie willen verbeteren, zullen onafhankelijk van elkaar verschillende AI-platforms en plug-ins implementeren, vaak zonder rekening te houden met de beveiligingsimplicaties. Dit creëert een complex web van ongeoorloofd SaaS-gebruik, waarbij gevoelige bedrijfsgegevens – van PII en financiële gegevens tot intellectueel eigendom – onbedoeld kunnen worden geëxfiltreerd naar Large Language Models (LLM's) van derden.

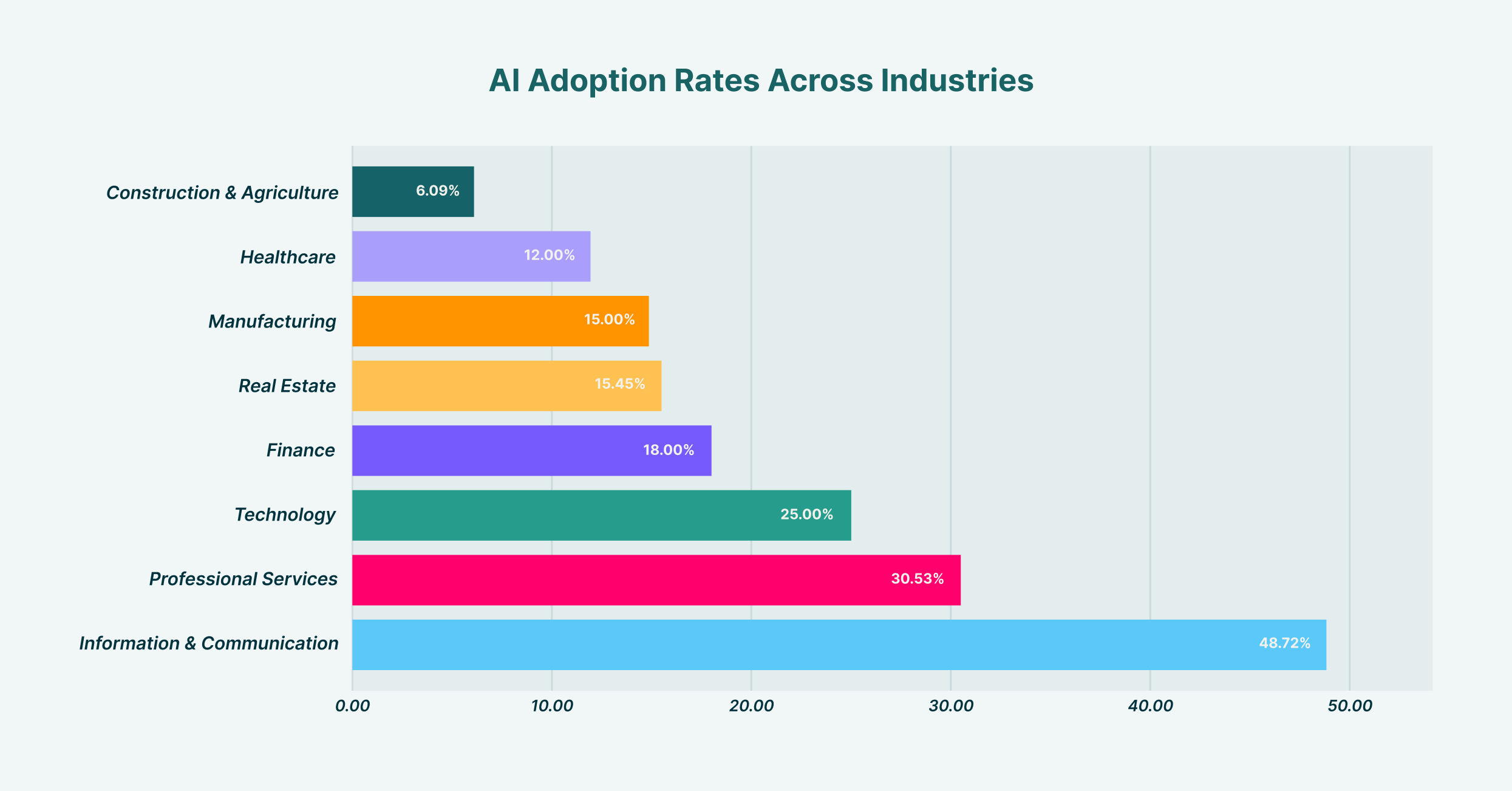

De adoptie van AI verschilt aanzienlijk per sector, waarbij Informatie & Communicatie met 48.7% het hoogst scoort en Bouw & Landbouw met 6.1% het laagst.

Het opzetten van robuuste AI-governance vereist het samenstellen van een cross-functioneel team, doorgaans bestaande uit vertegenwoordigers van IT, security, juridische zaken en de bedrijfsafdeling. Deze commissie heeft als taak het standpunt van de organisatie ten aanzien van AI te bepalen. Wat is onze risicobereidheid? Welke use cases worden aangemoedigd en welke zijn verboden? Wie is verantwoordelijk wanneer zich een AI-gerelateerd incident voordoet? Het beantwoorden van deze vragen biedt de duidelijkheid die nodig is om beleid en controles te ontwikkelen. Zonder deze top-down strategische sturing wordt elke poging tot risicomanagement een reeks onsamenhangende, reactieve maatregelen in plaats van een samenhangende verdediging. Dit governancekader vormt de blauwdruk voor alle daaropvolgende beveiligingsinspanningen en zorgt ervoor dat technologie, beleid en gebruikersgedrag op elkaar zijn afgestemd.

Het bouwen van uw AI-risicomanagementkader

Met een bestaande governancestructuur is de volgende stap het opzetten van een formeel AI-risicomanagementkader. Dit kader operationaliseert uw governanceprincipes en vertaalt de strategie op hoog niveau naar concrete, herhaalbare processen. Het biedt een gestructureerde methode voor het identificeren, beoordelen, beperken en monitoren van AI-gerelateerde risico's binnen de organisatie. In plaats van het wiel opnieuw uit te vinden, kunnen organisaties bestaande modellen, zoals het NIST AI Risk Management Framework, aanpassen aan hun specifieke operationele context en dreigingslandschap.

De ontwikkeling van een effectief AI-risicomanagementkader moet een methodisch proces zijn. Het begint met het maken van een uitgebreide inventarisatie van alle gebruikte AI-systemen; zowel goedgekeurde als niet-goedgekeurde. Deze eerste ontdekkingsfase is cruciaal; je kunt niet beschermen wat je niet kunt zien. Na de ontdekking moet het kader procedures voor risicobeoordeling beschrijven en scores toekennen op basis van factoren zoals het type data dat wordt verwerkt, de mogelijkheden van het model en de integratie ervan met andere kritieke systemen. Op basis van deze beoordeling worden vervolgens mitigatiestrategieën ontworpen, variërend van technische controles en gebruikerstraining tot een volledig verbod op risicovolle toepassingen. Ten slotte moet het kader een cadans bevatten voor continue monitoring en evaluatie, omdat zowel het AI-ecosysteem als het gebruik ervan door uw organisatie voortdurend evolueert. Er bestaan verschillende AI-risicomanagementkaders, maar de meest succesvolle zijn die welke geen statische documenten zijn, maar levende, ademende componenten van het beveiligingsprogramma van de organisatie.

Het categoriseren van AI-risico's: van data-exfiltratie tot modelvergiftiging

Een kerncomponent van AI en risicomanagement is het begrijpen van de specifieke soorten bedreigingen waarmee u te maken krijgt. De risico's zijn niet monolithisch; ze bestrijken een breed spectrum, van inbreuken op de privacy van gegevens tot geavanceerde aanvallen op de AI-modellen zelf. Een van de meest directe en veelvoorkomende bedreigingen is datalekken. Stelt u zich eens voor dat een marketinganalist een lijst met waardevolle leads, compleet met contactgegevens, in een openbare GenAI-tool plakt om gepersonaliseerde outreach-e-mails op te stellen. Op dat moment zijn gevoelige klantgegevens gehackt en maken ze nu deel uit van de trainingsgegevens van de LLM, buiten de controle van uw organisatie en mogelijk in strijd met regelgeving inzake gegevensbescherming zoals de AVG of CCPA.

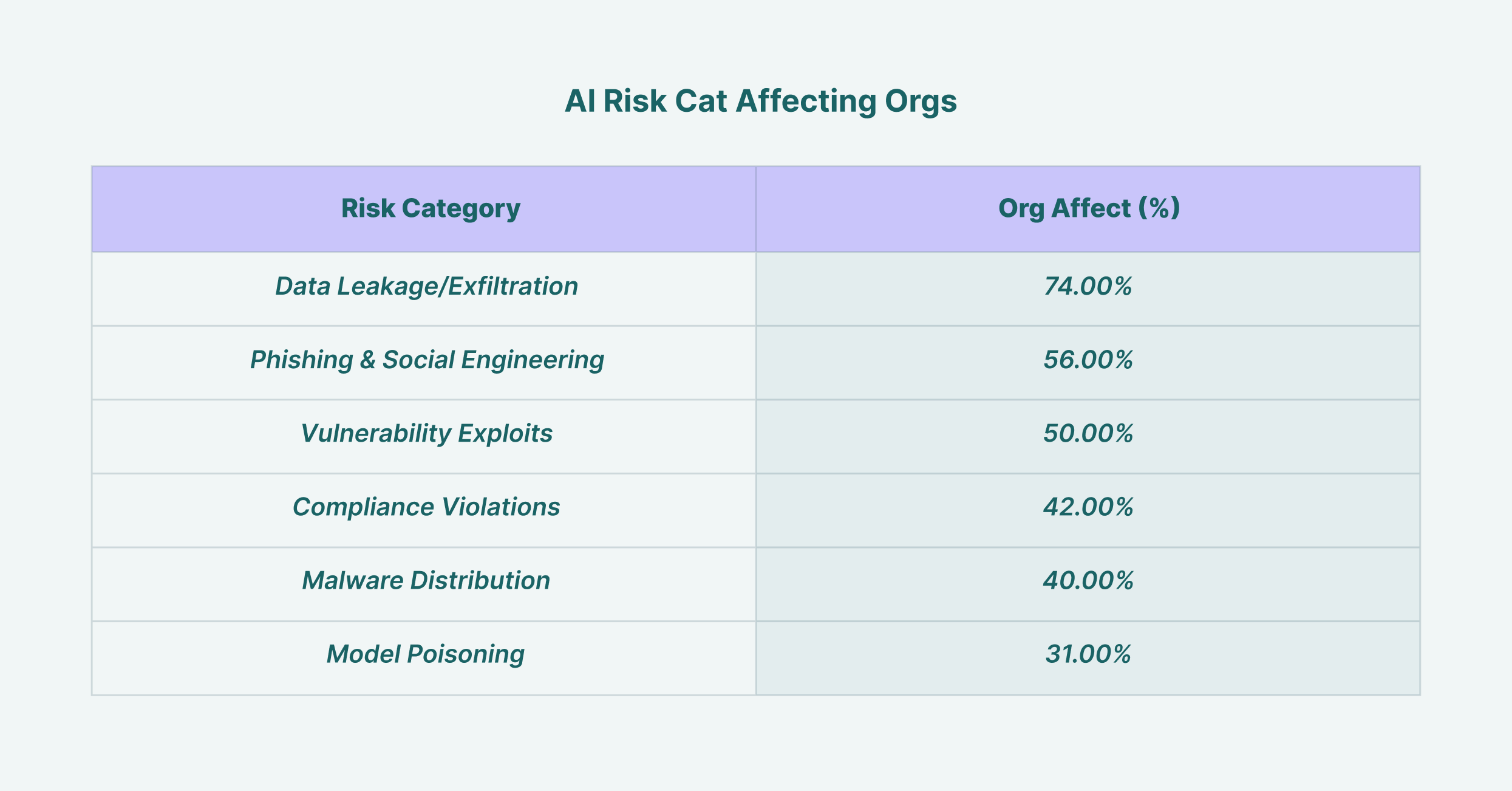

Datalekken treffen 74% van de organisaties, waardoor het het meest voorkomende AI-beveiligingsrisico is, gevolgd door phishingaanvallen met 56%.

Naast datalekken moeten beveiligingsmanagers ook omgaan met geavanceerdere bedreigingen. Modelvergiftiging treedt op wanneer een aanvaller opzettelijk schadelijke gegevens aan een model voedt tijdens de trainingsfase, waardoor het model bevooroordeelde, onjuiste of schadelijke output produceert. Evasion-aanvallen omvatten het creëren van input die specifiek is ontworpen om de beveiligingsfilters van een AI-systeem te omzeilen. Voor CISO's betekent effectief gebruik van AI in risicomanagement ook het inzetten van AI-gestuurde beveiligingstools om juist deze bedreigingen te detecteren. Geavanceerde bedreigingsdetectiesystemen kunnen gebruikersgedrag en datastromen analyseren om afwijkende activiteiten te identificeren die wijzen op een AI-gerelateerd beveiligingsincident, waardoor de technologie van een bron van risico verandert in een onderdeel van de oplossing.

De cruciale rol van een AI-beveiligingsbeleid

Om uw raamwerk te vertalen naar duidelijke richtlijnen voor uw medewerkers, is een specifiek AI-beveiligingsbeleid ononderhandelbaar. Dit document dient als gezaghebbende bron voor het acceptabele gebruik van AI binnen de organisatie. Het moet duidelijk, beknopt en gemakkelijk toegankelijk zijn voor alle medewerkers, zonder ruimte voor onduidelijkheid. Een goed opgesteld AI-beveiligingsbeleid gaat verder dan simpele 'do's en don'ts' en biedt context en uitleg. Waarom Er zijn bepaalde beperkingen ingesteld om een cultuur van beveiligingsbewustzijn te bevorderen in plaats van louter naleving.

Het beleid moet verschillende belangrijke gebieden expliciet definiëren. Ten eerste moeten alle goedgekeurde AI-tools worden vermeld, samen met de procedure voor het aanvragen van de evaluatie van een nieuwe tool. Dit voorkomt de verspreiding van schaduw-AI. Ten tweede moeten er duidelijke richtlijnen voor gegevensverwerking worden opgesteld, waarin wordt gespecificeerd welke soorten bedrijfsinformatie (bijvoorbeeld openbaar, intern, vertrouwelijk, beperkt) met welke categorie AI-tools mogen worden gebruikt. Zo kan het gebruik van een openbare GenAI-tool voor het samenvatten van openbaar beschikbare nieuwsartikelen acceptabel zijn, maar het gebruik ervan voor het analyseren van vertrouwelijke financiële prognoses is ten strengste verboden. Het beleid moet ook de verantwoordelijkheden van gebruikers, de gevolgen van niet-naleving en het protocol voor incidentrespons bij vermoedelijke AI-gerelateerde inbreuken beschrijven, zodat iedereen zijn of haar rol in de bescherming van de organisatie begrijpt.

Modellen en plug-ins evalueren: een focus op AI-risicomanagement van derden

Het moderne AI-ecosysteem is gebouwd op een complexe toeleveringsketen van modellen, platforms en plug-ins die door derden zijn ontwikkeld. Deze realiteit maakt AI-risicomanagement door derden een cruciale pijler van uw algehele beveiligingsstrategie. Elke keer dat een medewerker een nieuwe plug-in voor zijn of haar AI-assistent activeert of uw ontwikkelteam een API van derden integreert, vergroot dit het aanvalsoppervlak van uw organisatie. Elk van deze externe componenten brengt zijn eigen reeks potentiële kwetsbaarheden, gegevensbeschermingsbeleid en beveiligingshoudingen met zich mee, die nu door uw organisatie worden overgenomen.

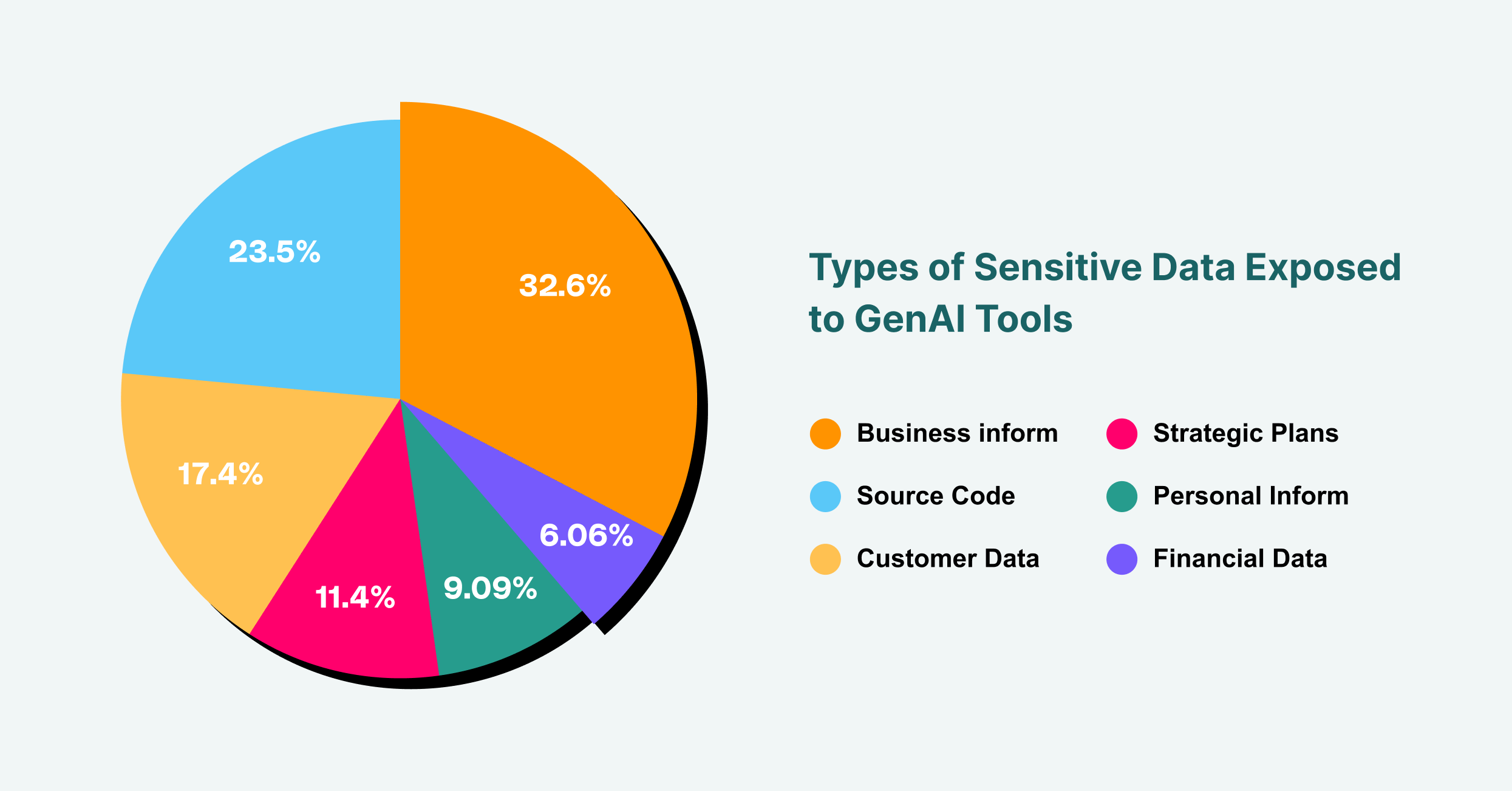

Bedrijfsinformatie is goed voor 43% van de gevoelige gegevens die GenAI blootstelt, gevolgd door broncode met 31% en klantgegevens met 23%.

Een rigoureus evaluatieproces is daarom essentieel. Voordat een AI-tool of -component van derden wordt goedgekeurd voor gebruik, moet deze worden onderworpen aan een grondige beveiligings- en privacybeoordeling. Dit omvat het nauwkeurig onderzoeken van de beveiligingscertificeringen, gegevensverwerkingspraktijken en incidentresponsmogelijkheden van de leverancier. Welke gegevens verzamelt de tool? Waar worden deze opgeslagen en wie heeft er toegang toe? Heeft de leverancier een geschiedenis van beveiligingsinbreuken? Voor AI-plug-ins, die een groeiend doelwit vormen voor browsergebaseerde aanvallen, zou het beoordelingsproces nog strenger moeten zijn. Vragen die u kunt stellen zijn onder andere: Welke machtigingen vereist de plug-in? Wie is de ontwikkelaar? Is de code gecontroleerd? Door elke AI-service van derden met dezelfde mate van nauwkeurigheid te behandelen als elke andere kritische leverancier, kunt u het risico beperken dat een supply chain-aanval uw organisatie in gevaar brengt.

Implementatie van AI-risicomanagementtools

Beleid en proces zijn fundamenteel, maar ze zijn onvoldoende zonder technische handhaving. Dit is waar AI-risicomanagementtools essentieel worden. Deze oplossingen bieden de zichtbaarheid en controle die nodig zijn om ervoor te zorgen dat uw AI-beveiligingsbeleid in de praktijk wordt nageleefd, niet alleen in theorie. Aangezien de primaire interface voor de meeste gebruikers die met GenAI werken de webbrowser is, zijn tools die op deze laag kunnen werken bij uitstek geschikt om effectief toezicht te bieden.

Enterprise browserextensies of -platforms, zoals LayerX, bieden een krachtig mechanisme voor AI-risicobeheer. Ze kunnen al het GenAI-gebruik binnen de organisatie ontdekken en in kaart brengen, waardoor een realtime inventaris ontstaat van welke gebruikers toegang hebben tot welke platforms. Deze zichtbaarheid is de eerste stap in het uitbannen van schaduw-AI. Van daaruit kunnen deze tools gedetailleerde, op risico gebaseerde beschermingsmaatregelen afdwingen. U kunt bijvoorbeeld een beleid configureren dat voorkomt dat gebruikers tekst die als 'vertrouwelijk' is aangemerkt, in een openbare AI-chatbot plakken, of dat gebruikers waarschuwt voordat ze een gevoelig document uploaden. Deze beschermingslaag bewaakt en beheert de gegevensstroom tussen de browser van de gebruiker en het web en fungeert in feite als een Data Loss Prevention (DLP)-oplossing die specifiek is afgestemd op het AI-tijdperk. De juiste AI-risicobeheertools overbruggen de kloof tussen beleid en realiteit en bieden de technische middelen om uw governancebeslissingen af te dwingen.

Incidentafhandeling en -respons in het tijdperk van AI

Zelfs met de beste preventieve maatregelen kunnen incidenten zich nog steeds voordoen. Hoe uw organisatie reageert, is een bepalende factor bij het minimaliseren van de impact van een inbreuk. Een effectief incidentresponsplan voor AI moet zowel specifiek als goed geoefend zijn. Wanneer een waarschuwing wordt geactiveerd, of dit nu door een gebruikersrapport of een geautomatiseerde detectie door een van uw beveiligingstools is, heeft het responsteam een duidelijk draaiboek nodig om te volgen.

De eerste stap is containment. Als een gebruiker onbedoeld gevoelige gegevens naar een LLM heeft gelekt, is de eerste prioriteit het intrekken van de toegang en het voorkomen van verdere blootstelling. Dit kan betekenen dat de toegang van de gebruiker tot de tool tijdelijk wordt uitgeschakeld of dat de machine van het netwerk wordt geïsoleerd. De volgende fase is onderzoek. Welke gegevens zijn gelekt? Wie was verantwoordelijk? Hoe hebben onze controles gefaald? Deze forensische analyse is cruciaal om de hoofdoorzaak te achterhalen en herhaling te voorkomen. Ten slotte moet het plan ingaan op uitroeiing en herstel, wat inhoudt dat de betrokken partijen worden geïnformeerd zoals wettelijk vereist, dat stappen worden ondernomen om de gegevens indien mogelijk door de AI-leverancier te laten verwijderen, en dat het beveiligingsbeleid en de controles worden bijgewerkt op basis van de geleerde lessen. Een volwassen AI- en risicomanagementhouding betekent dat u net zo goed voorbereid bent om te reageren op een incident als om er een te voorkomen.

Uw AI-risicohouding volgen en verbeteren

AI-risicomanagement is geen eenmalig project; het is een continue cyclus van beoordeling, beperking en verbetering. Het dreigingslandschap is dynamisch en er verschijnen voortdurend nieuwe AI-tools en aanvalsvectoren. Het is daarom essentieel om de AI-risicopositie van uw organisatie in de loop der tijd te volgen om ervoor te zorgen dat uw verdediging effectief blijft. Dit vereist voortdurende monitoring en het gebruik van statistieken om uw risiconiveau en de prestaties van uw controlemechanismen te kwantificeren.

Key Performance Indicators (KPI's) kunnen onder meer het aantal gedetecteerde niet-goedgekeurde AI-tools, het aantal voorkomen datalekken en het percentage medewerkers dat een AI-beveiligingstraining heeft afgerond, omvatten. Regelmatige audits en penetratietests, specifiek gericht op AI-systemen, kunnen ook waardevolle inzichten verschaffen in zwakke punten in uw beveiliging. Door uw aanpak continu te meten en te verfijnen, creëert u een veerkrachtig beveiligingsprogramma dat zich aanpast aan de veranderende uitdagingen van de AI-gedreven wereld. Deze proactieve houding zorgt ervoor dat uw organisatie de kracht van AI vol vertrouwen en veilig kan blijven benutten, waardoor een potentiële bron van catastrofale risico's wordt omgezet in een goed beheerd strategisch voordeel.