Интегрирането на генеративния изкуствен интелект в корпоративните работни процеси не е предложение, насочено към бъдещето; то се случва точно сега, с темпове, които често изпреварват възможностите за сигурност и управление. За всяко документирано, санкционирано използване на инструмент с изкуствен интелект, който повишава производителността, има безброй случаи на „скрита“ употреба, излагайки организациите на значителни заплахи. Предизвикателството пред анализаторите по сигурността, CISO и ИТ лидерите е ясно: как да реализираме иновациите, които изкуственият интелект обещава, без да поемаме неприемливи рискове? Отговорът се крие в дисциплиниран, проактивен подход към управлението на риска, свързан с изкуствения интелект. Не става въпрос за блокиране на напредъка; става въпрос за изграждане на предпазни мерки, които позволяват на вашата организация да се ускорява безопасно.

Нарастващата необходимост от управление на изкуствения интелект

Преди да може да се внедри каквато и да е ефективна стратегия за управление на риска, трябва да се изградят основите на управлението на ИИ. Бързото, децентрализирано приемане на инструменти с ИИ означава, че без формална структура за управление организациите работят на тъмно. Служителите, нетърпеливи да подобрят своята ефективност, самостоятелно ще внедряват различни платформи и плъгини с ИИ, често без да обмислят последиците за сигурността. Това създава сложна мрежа от несанкционирано използване на SaaS, където чувствителни корпоративни данни – от лични данни и финансови записи до интелектуална собственост – могат да бъдат неволно изнесени към големи езикови модели (LLM) на трети страни.

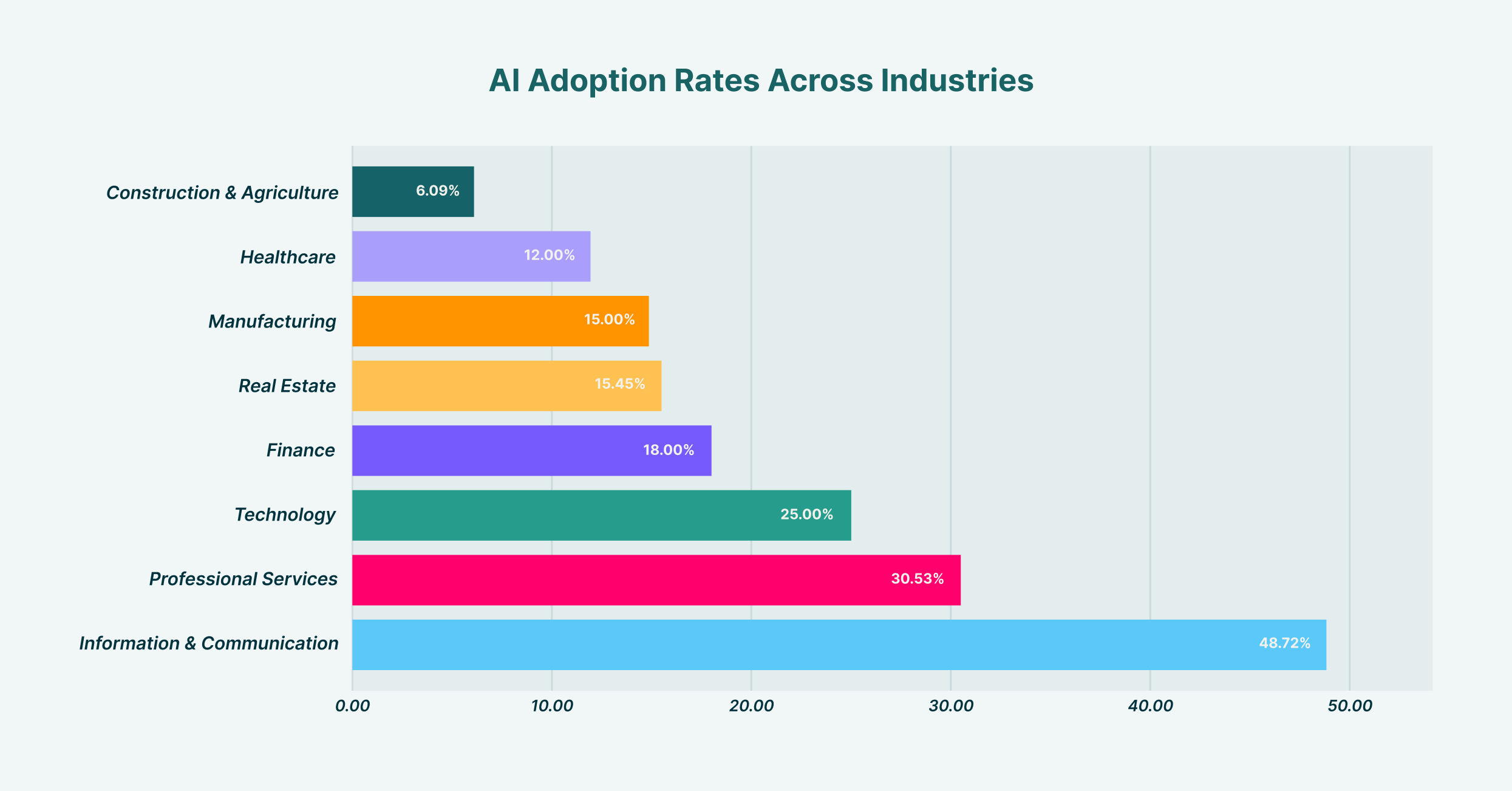

Въвеждането на изкуствен интелект варира значително в различните индустрии, като „Информация и комуникации“ е водещо с 48.7%, а „Строителство и селско стопанство“ е с най-нисък дял с 6.1%.

Установяването на стабилно управление на ИИ включва създаването на междуфункционален екип, обикновено включващ представители на ИТ, сигурност, правния и бизнес отдела. Този комитет е натоварен със задачата да определи позицията на организацията по отношение на ИИ. Какъв е нашият апетит за риск? Кои случаи на употреба се насърчават и кои са забранени? Кой носи отговорност, когато възникне инцидент, свързан с ИИ? Отговорите на тези въпроси осигуряват яснотата, необходима за изграждане на политики и контроли. Без тази стратегическа насока „отгоре надолу“, всеки опит за управление на риска се превръща в поредица от несвързани, реактивни мерки, а не в сплотена защита. Тази рамка за управление се превръща в план за всички последващи усилия за сигурност, гарантирайки, че технологиите, политиките и поведението на потребителите са съгласувани.

Изграждане на рамка за управление на риска от изкуствен интелект

След като е налице структура на управление, следващата стъпка е изграждането на официална рамка за управление на риска, свързан с изкуствения интелект (ИИ). Тази рамка операционализира вашите принципи на управление, превръщайки стратегията на високо ниво в конкретни, повтарящи се процеси. Тя предоставя структуриран метод за идентифициране, оценка, смекчаване и наблюдение на рисковете, свързани с ИИ, в цялата организация. Вместо да преоткриват колелото, организациите могат да адаптират установени модели, като например рамката за управление на риска, свързан с ИИ, на NIST, за да отговарят на специфичния си оперативен контекст и пейзаж от заплахи.

Разработването на ефективна рамка за управление на риска, свързан с изкуствения интелект, трябва да бъде методичен процес. Той започва със създаването на цялостен опис на всички използвани системи с изкуствен интелект; както санкционирани, така и несанкционирани. Тази първоначална фаза на откриване е критична; не можете да защитите това, което не можете да видите. След откриването, рамката трябва да очертае процедури за оценка на риска, като присвоява оценки въз основа на фактори като вида на обработваните данни, възможностите на модела и неговата интеграция с други критични системи. След това се разработват стратегии за смекчаване въз основа на тази оценка, вариращи от технически контрол и обучение на потребителите до пълна забрана на приложения с висок риск. И накрая, рамката трябва да включва ритъм за непрекъснато наблюдение и преглед, тъй като както екосистемата с изкуствен интелект, така и използването ѝ от вашата организация ще се развиват непрекъснато. Съществуват различни рамки за управление на риска, свързан с изкуствен интелект, но най-успешните са тези, които не са статични документи, а живи, дишащи компоненти на програмата за сигурност на организацията.

Категоризиране на рисковете, свързани с изкуствения интелект: от изтичане на данни до отравяне на модели

Основен компонент на изкуствения интелект и управлението на риска е разбирането на специфичните видове заплахи, пред които сте изправени. Рисковете не са монолитни; те обхващат цял спектър от нарушения на поверителността на данните до сложни атаки срещу самите модели на изкуствен интелект. Една от най-непосредствените и често срещани заплахи е изтичането на данни. Представете си маркетингов анализатор, който поставя списък с високоценни потенциални клиенти, заедно с информация за контакт, в публичен инструмент на GenAI, за да изготвя персонализирани имейли за комуникация. В този момент чувствителните данни за клиентите са били изтръгнати и сега са част от данните за обучение на LLM, извън контрола на вашата организация и в потенциално нарушение на разпоредбите за защита на данните, като GDPR или CCPA.

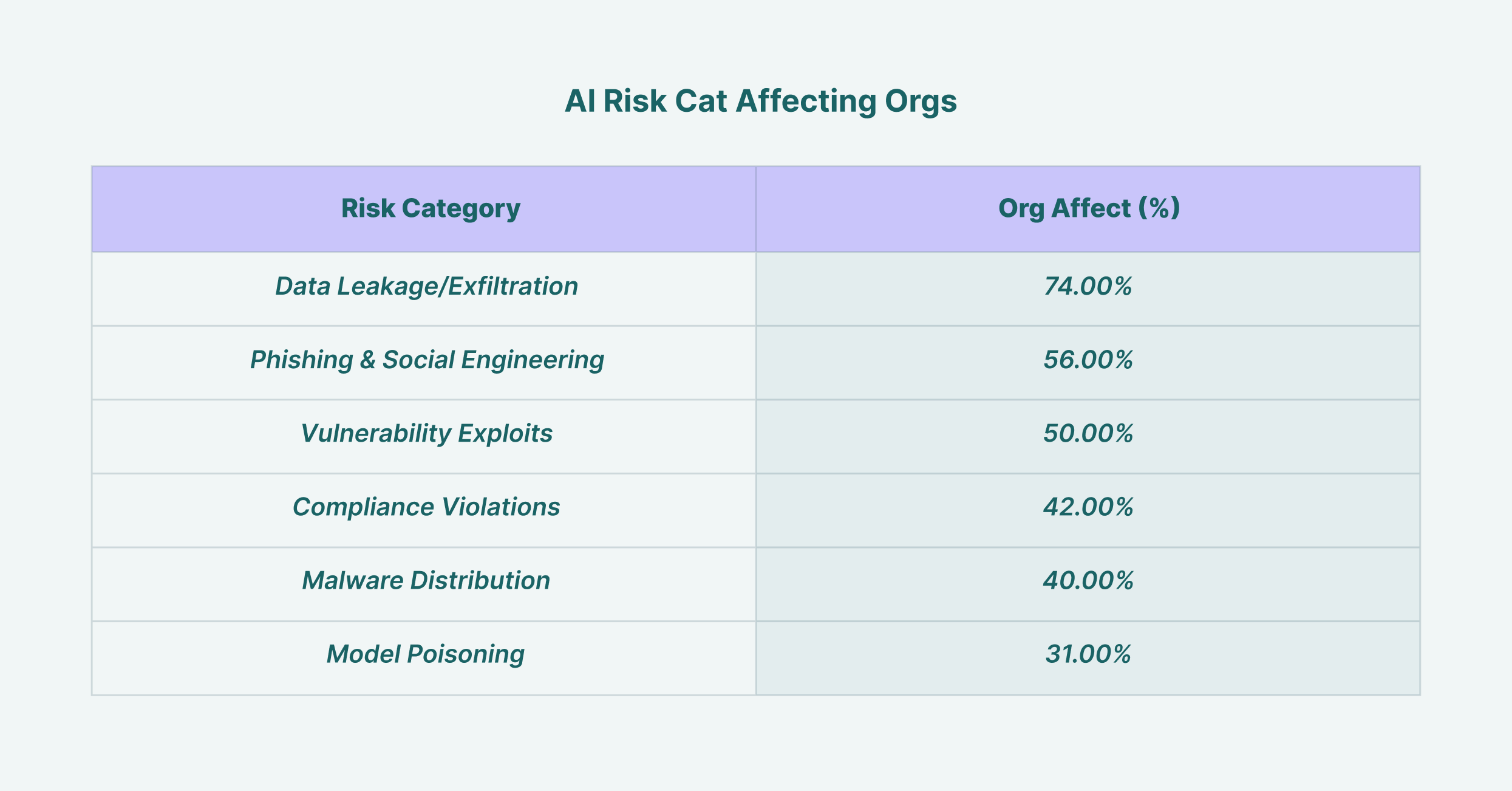

Изтичането на данни засяга 74% от организациите, което го прави най-разпространеният риск за сигурността, свързан с изкуствения интелект, следван от фишинг атаките с 56%.

Освен изтичането на данни, лидерите по сигурността трябва да се справят и с по-напреднали заплахи. Отравянето на модела се случва, когато нападател умишлено подава злонамерени данни към модел по време на фазата му на обучение, което води до генериране на предубедени, неправилни или вредни резултати. Атаките за избягване включват създаване на входни данни, които са специално проектирани да заобиколят филтрите за сигурност на системата с изкуствен интелект. За CISO ефективното използване на изкуствен интелект в управлението на риска означава също така използване на инструменти за сигурност, задвижвани от изкуствен интелект, за откриване на тези заплахи. Усъвършенстваните системи за откриване на заплахи могат да анализират поведението на потребителите и потоците от данни, за да идентифицират аномални дейности, показателни за инцидент със сигурността, свързан с изкуствен интелект, превръщайки технологията от източник на риск в компонент на решението.

Критичната роля на политиката за сигурност на изкуствения интелект

За да превърнете рамката си в ясни директиви за служителите си, е необходима специална политика за сигурност на ИИ, която не подлежи на обсъждане. Този документ служи като авторитетен източник за приемливото използване на ИИ в организацията. Той трябва да бъде ясен, кратък и лесно достъпен за всички служители, без да оставя място за неясноти. Добре разработената политика за сигурност на ИИ надхвърля простите „правила и забрани“ и предоставя контекст, обясняващ... защо Въведени са определени ограничения, за да се насърчи култура на осъзнаване на сигурността, а не просто спазване на изискванията.

Политиката трябва изрично да дефинира няколко ключови области. Първо, тя трябва да изброява всички санкционирани и одобрени инструменти с изкуствен интелект, заедно с процеса за заявяване на оценка на нов инструмент. Това предотвратява разпространението на скрит изкуствен интелект. Второ, тя трябва да установи ясни насоки за обработка на данни, като уточнява какви видове корпоративна информация (напр. публична, вътрешна, поверителна, ограничена) могат да се използват с коя категория инструменти с изкуствен интелект. Например, използването на публичен инструмент GenAI за обобщаване на публично достъпни новинарски статии може да е приемливо, но използването му за анализ на поверителни финансови прогнози би било строго забранено. Политиката трябва също така да очертае отговорностите на потребителите, последствията от неспазване и протокола за реагиране при инциденти при предполагаеми нарушения, свързани с изкуствен интелект, като гарантира, че всеки разбира ролята си в защитата на организацията.

Оценка на модели и плъгини: Фокус върху управлението на риска от трети страни, свързан с изкуствен интелект

Съвременната екосистема от изкуствен интелект е изградена върху сложна верига за доставки на модели, платформи и плъгини, разработени от трети страни. Тази реалност прави управлението на риска от ИИ от трети страни критичен стълб на вашата цялостна стратегия за сигурност. Всеки път, когато служител активира нов плъгин за своя ИИ асистент или вашият екип за разработка интегрира API на трета страна, той разширява повърхността за атака на вашата организация. Всеки от тези външни компоненти носи свой собствен набор от потенциални уязвимости, политики за поверителност на данните и позиции за сигурност, които сега се наследяват от вашата организация.

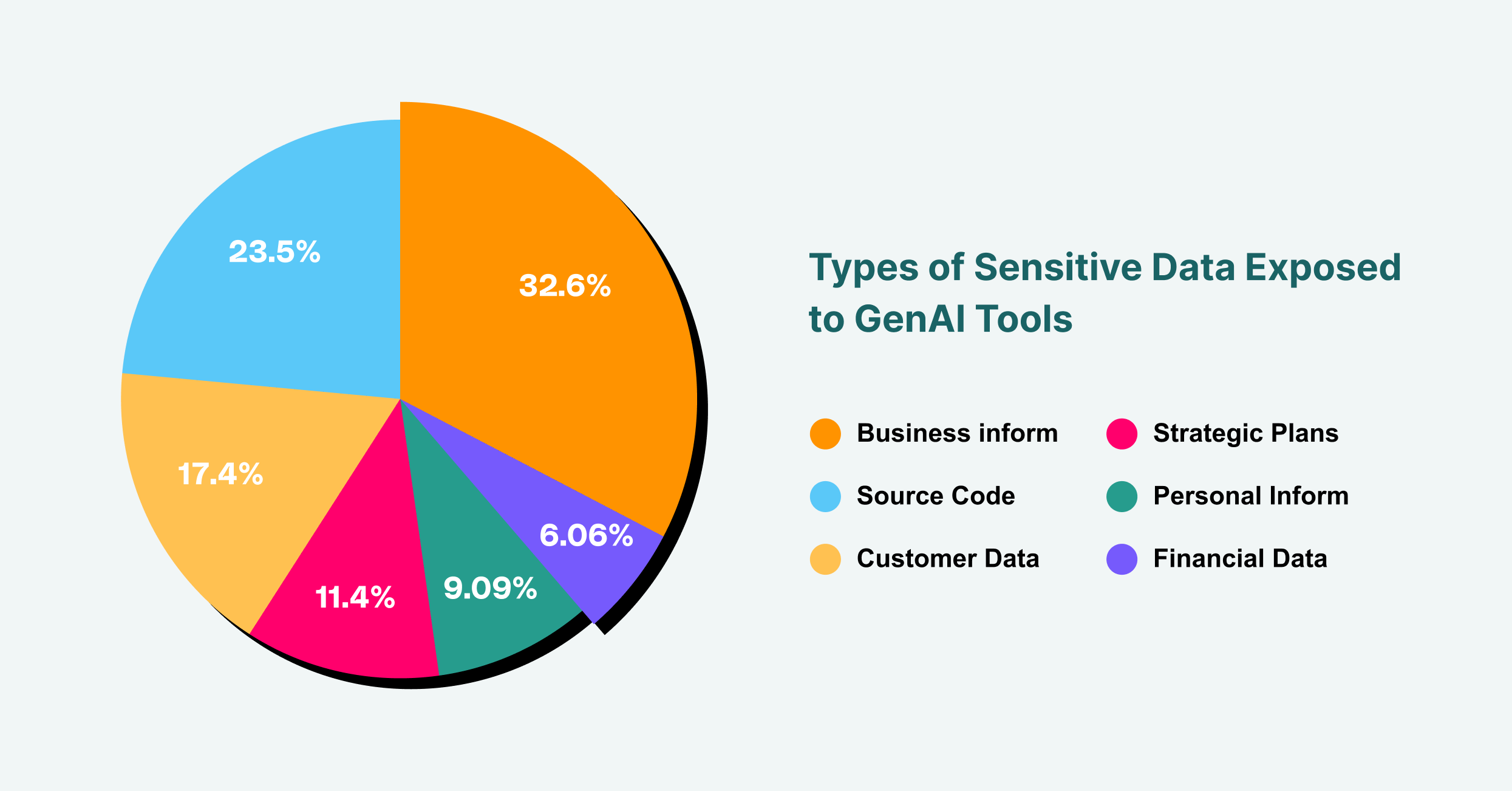

Бизнес информацията представлява 43% от излагането на чувствителни данни на GenAI, следвана от изходния код с 31% и клиентските данни с 23%.

Следователно, строгият процес на оценка е от съществено значение. Преди да бъде одобрен за употреба който и да е инструмент или компонент с изкуствен интелект на трета страна, той трябва да бъде подложен на задълбочен преглед на сигурността и поверителността. Това включва проверка на сертификатите за сигурност на доставчика, практиките за обработка на данни и възможностите за реагиране при инциденти. Какви данни събира инструментът? Къде се съхраняват и кой има достъп до тях? Има ли доставчикът история на нарушения на сигурността? За плъгините с изкуствен интелект, които са нарастващ вектор за атаки, базирани на браузър, процесът на проверка трябва да бъде още по-строг. Въпросите, които трябва да се зададат, включват: Какви разрешения изисква плъгинът? Кой е разработчикът? Одитиран ли е кодът му? Като третирате всяка услуга с изкуствен интелект на трета страна със същото ниво на контрол, както всеки друг критичен доставчик, можете да намалите риска от атака срещу веригата за доставки, която компрометира вашата организация.

Внедряване на инструменти за управление на риска от изкуствен интелект

Политиката и процесът са основополагащи, но те са недостатъчни без техническо прилагане. Именно тук инструментите за управление на риска, свързан с изкуствения интелект, стават от съществено значение. Тези решения осигуряват видимостта и контрола, необходими за гарантиране, че вашата политика за сигурност на ИИ се спазва на практика, а не само на теория. Като се има предвид, че основният интерфейс за повечето потребители, взаимодействащи с GenAI, е уеб браузърът, инструментите, които могат да работят на това ниво, са уникално позиционирани да осигуряват ефективен надзор.

Разширенията или платформите за корпоративни браузъри, като LayerX, предлагат мощен механизъм за управление на риска, свързан с ИИ. Те могат да откриват и картографират цялото използване на GenAI в организацията, предоставяйки инвентаризация в реално време на това кои потребители имат достъп до кои платформи. Тази видимост е първата стъпка за спиране на скрития ИИ. Оттам нататък тези инструменти могат да наложат подробни, базирани на риска предпазни мерки. Например, можете да конфигурирате политика, която не позволява на потребителите да поставят текст, идентифициран като „поверителен“, в публичен чатбот с ИИ или която предупреждава потребителите, преди да качат чувствителен документ. Този слой защита наблюдава и контролира потока от данни между браузъра на потребителя и мрежата, като ефективно действа като решение за предотвратяване на загуба на данни (DLP), специално пригодено за ерата на ИИ. Правилните инструменти за управление на риска, свързан с ИИ, преодоляват разликата между политиката и реалността, предоставяйки техническите средства за прилагане на вашите решения за управление.

Справяне с инциденти и реагиране в ерата на изкуствения интелект

Дори и с най-добрите превантивни мерки, все още могат да възникнат инциденти. Начинът, по който вашата организация реагира, е определящ фактор за минимизиране на въздействието на нарушението. Ефективният план за реагиране при инциденти с изкуствен интелект трябва да бъде едновременно специфичен и добре обмислен. Когато се задейства предупреждение, независимо дали от потребителски доклад или от автоматизирано откриване от един от вашите инструменти за сигурност, екипът за реагиране се нуждае от ясен наръчник, който да следва.

Първата стъпка е ограничаването. Ако потребител неволно е изтекъл чувствителни данни към LLM, непосредственият приоритет е да се отнеме достъпът и да се предотврати по-нататъшно излагане. Това може да включва временно деактивиране на достъпа на потребителя до инструмента или дори изолиране на машината му от мрежата. Следващата фаза е разследване. Какви данни са изтекли? Кой е отговорен? Как нашите контролни механизми се провалиха? Този криминалистичен анализ е от решаващо значение за разбирането на първопричината и предотвратяването на повторение. И накрая, планът трябва да обхваща премахването и възстановяването, което включва уведомяване на засегнатите страни, както се изисква от закона, предприемане на стъпки за премахване на данните от доставчика на ИИ, ако е възможно, и актуализиране на политиките и контролите за сигурност въз основа на извлечените поуки. Зрялата позиция по отношение на ИИ и управлението на риска означава да сте също толкова подготвени да реагирате на инцидент, колкото и да предотвратите такъв.

Проследяване и подобряване на вашата позиция по отношение на риска, свързан с изкуствения интелект

Управлението на риска, свързан с изкуствения интелект, не е еднократен проект; това е непрекъснат цикъл на оценка, смекчаване и подобрение. Пейзажът от заплахи е динамичен, като постоянно се появяват нови инструменти, свързани с изкуствения интелект, и вектори на атаки. Следователно, проследяването на рисковете, свързани с изкуствения интелект, във вашата организация във времето е от съществено значение, за да се гарантира, че вашите защитни механизми остават ефективни. Това изисква ангажимент за непрекъснато наблюдение и използване на показатели за количествено определяне на нивото на риск и ефективността на вашите контроли.

Ключовите показатели за ефективност (KPI) могат да включват броя на откритите несанкционирани инструменти с изкуствен интелект, обема на предотвратените инциденти с изтичане на данни и процента на служителите, завършили обучение за сигурност с изкуствен интелект. Редовните одити и тестовете за проникване, специално фокусирани върху системите с изкуствен интелект, също могат да предоставят безценна информация за слабостите във вашата защита. Чрез непрекъснато измерване и усъвършенстване на вашия подход, вие създавате устойчива програма за сигурност, която се адаптира към променящите се предизвикателства на света, задвижван от изкуствен интелект. Тази проактивна позиция гарантира, че вашата организация може да продължи да използва силата на изкуствения интелект уверено и сигурно, превръщайки потенциален източник на катастрофален риск в добре управлявано стратегическо предимство.