Ang pagsasama ng Generative AI sa mga workflow ng enterprise ay hindi isang panghinaharap na panukala; ito ay nangyayari ngayon, sa bilis na kadalasang higit sa mga kakayahan sa seguridad at pamamahala. Para sa bawat dokumentado at sinang-ayunan na paggamit ng isang tool ng AI na nagpapalakas ng pagiging produktibo, mayroong hindi mabilang na mga pagkakataon ng paggamit ng "anino", na naglalantad sa mga organisasyon sa mga makabuluhang banta. Ang hamon para sa mga security analyst, CISO, at mga pinuno ng IT ay malinaw: paano natin ie-enable ang innovation na ipinangako ng AI nang hindi nag-iimbita ng mga hindi katanggap-tanggap na panganib? Ang sagot ay nakasalalay sa isang disiplinado, maagap na diskarte sa pamamahala ng peligro ng AI. Hindi ito tungkol sa pagharang sa pag-unlad; ito ay tungkol sa pagbuo ng mga guardrail na nagbibigay-daan sa iyong organisasyon na mapabilis nang ligtas.

Ang Lumalagong Pangangailangan ng AI Governance

Bago maipatupad ang anumang epektibong diskarte sa peligro, dapat na maitatag ang isang pundasyon ng pamamahala ng AI. Ang mabilis, desentralisadong pag-aampon ng mga tool ng AI ay nangangahulugan na walang pormal na istruktura ng pamamahala, ang mga organisasyon ay tumatakbo sa dilim. Ang mga empleyado, na sabik na pagbutihin ang kanilang kahusayan, ay malayang magpapatibay ng iba't ibang mga platform at plugin ng AI, kadalasan nang hindi isinasaalang-alang ang mga implikasyon sa seguridad. Lumilikha ito ng isang kumplikadong web ng hindi sinanksiyong paggamit ng SaaS, kung saan ang sensitibong data ng kumpanya; mula sa PII at mga rekord sa pananalapi hanggang sa intelektwal na pag-aari; maaaring hindi sinasadyang mai-exfiltrate sa mga third-party na Large Language Models (LLMs).

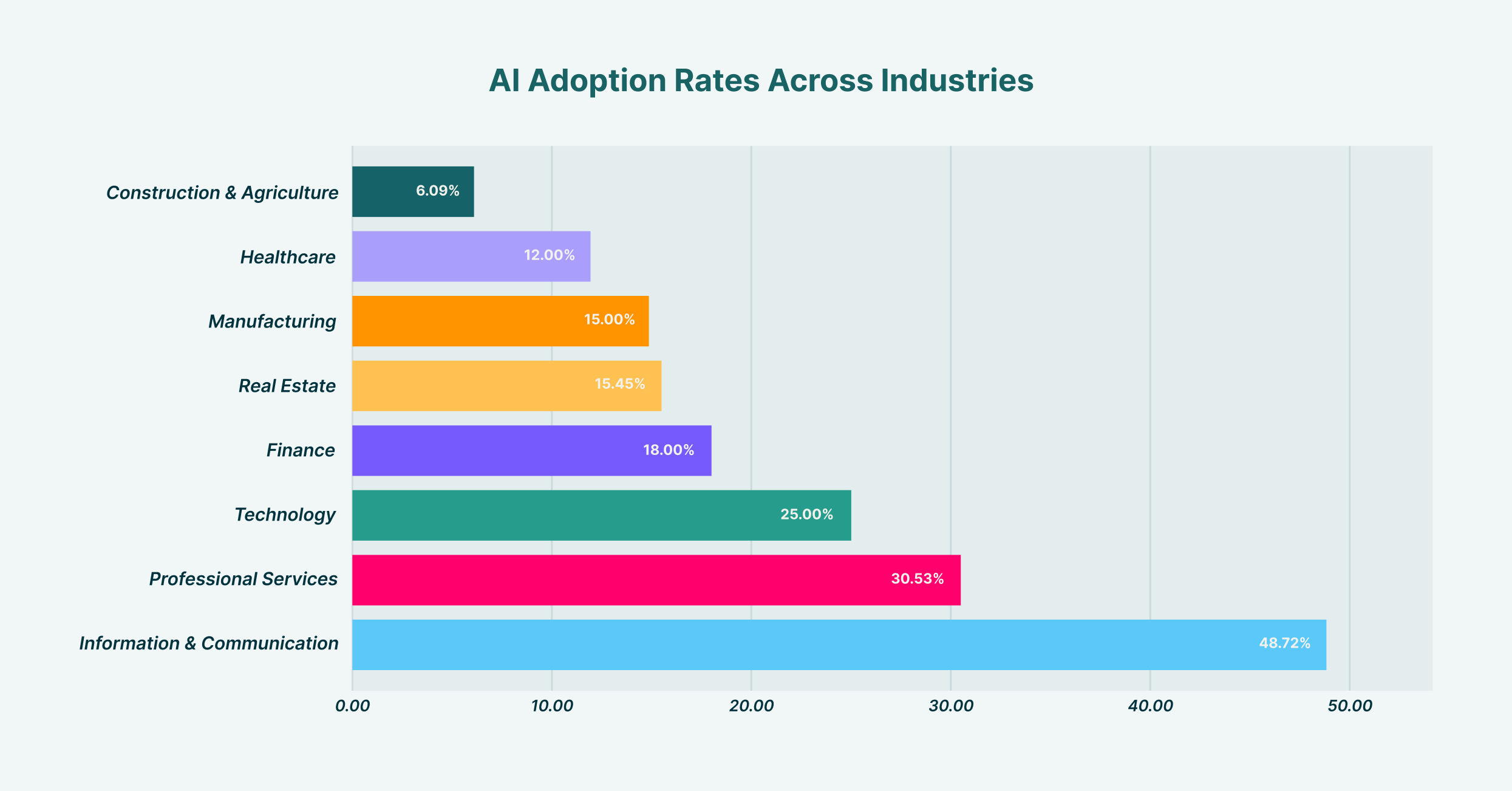

Malaki ang pagkakaiba-iba ng AI adoption sa mga industriya, kung saan ang Information & Communication ay nangunguna sa 48.7% at Construction & Agriculture sa pinakamababa na may 6.1%

Ang pagtatatag ng matatag na pamamahala sa AI ay nagsasangkot ng paglikha ng cross-functional na team, karaniwang kabilang ang mga kinatawan mula sa IT, seguridad, legal, at mga departamento ng negosyo. Ang komite na ito ay may tungkulin sa pagtukoy sa paninindigan ng organisasyon sa AI. Ano ang ating risk appetite? Aling mga kaso ng paggamit ang hinihikayat, at alin ang ipinagbabawal? Sino ang mananagot kapag may nangyaring insidente na nauugnay sa AI? Ang pagsagot sa mga tanong na ito ay nagbibigay ng kalinawan na kailangan upang bumuo ng mga patakaran at kontrol. Kung wala ang top-down na madiskarteng direksyon na ito, ang anumang pagtatangka sa pamamahala ng panganib ay nagiging isang serye ng magkahiwalay, reaktibong mga hakbang sa halip na isang magkakaugnay na depensa. Ang balangkas ng pamamahala na ito ay nagiging blueprint para sa lahat ng kasunod na pagsusumikap sa seguridad, na tinitiyak na ang teknolohiya, patakaran, at gawi ng user ay nakahanay.

Pagbuo ng Iyong AI Risk Management Framework

Sa pagkakaroon ng istruktura ng pamamahala, ang susunod na hakbang ay ang pagbuo ng isang pormal na AI risk management framework. Pinapatakbo ng balangkas na ito ang iyong mga prinsipyo sa pamamahala, na ginagawang kongkreto, nauulit na mga proseso ang mataas na antas na diskarte. Nagbibigay ito ng structured na paraan para sa pagtukoy, pagtatasa, pagpapagaan, at pagsubaybay sa mga panganib na nauugnay sa AI sa buong organisasyon. Sa halip na muling likhain ang gulong, maaaring iangkop ng mga organisasyon ang mga naitatag na modelo, gaya ng NIST AI Risk Management Framework, upang umangkop sa kanilang partikular na konteksto ng pagpapatakbo at tanawin ng pagbabanta.

Ang pagbuo ng isang epektibong balangkas ng pamamahala sa peligro ng AI ay dapat na isang pamamaraang proseso. Nagsisimula ito sa paglikha ng isang komprehensibong imbentaryo ng lahat ng AI system na ginagamit; parehong sanctioned at hindi sanctioned. Ang paunang bahagi ng pagtuklas na ito ay kritikal; hindi mo mapoprotektahan ang hindi mo nakikita. Kasunod ng pagtuklas, ang balangkas ay dapat magbalangkas ng mga pamamaraan para sa pagtatasa ng panganib, na nagtatalaga ng mga marka batay sa mga salik tulad ng uri ng data na pinoproseso, ang mga kakayahan ng modelo, at ang pagsasama nito sa iba pang mga kritikal na sistema. Ang mga diskarte sa pagpapagaan ay idinisenyo batay sa pagtatasa na ito, mula sa mga teknikal na kontrol at pagsasanay ng user hanggang sa tahasang pagbabawal sa mga application na may mataas na peligro. Sa wakas, ang balangkas ay dapat na may kasamang ritmo para sa patuloy na pagsubaybay at pagsusuri, dahil ang AI ecosystem at ang paggamit nito ng iyong organisasyon ay patuloy na magbabago. Mayroong iba't ibang mga balangkas ng pamamahala sa peligro ng AI, ngunit ang pinakamatagumpay ay ang mga hindi static na dokumento ngunit buhay, humihinga na mga bahagi ng programa ng seguridad ng organisasyon.

Pag-uuri ng Mga Panganib sa AI: Mula sa Data Exfiltration hanggang sa Model Poisoning

Ang pangunahing bahagi ng AI at pamamahala sa peligro ay ang pag-unawa sa mga partikular na uri ng mga banta na kinakaharap mo. Ang mga panganib ay hindi monolitik; sumasaklaw sila sa isang spectrum mula sa mga paglabag sa privacy ng data hanggang sa mga sopistikadong pag-atake laban sa mga modelo ng AI mismo. Ang isa sa mga pinaka-kaagad at karaniwang banta ay ang pagtagas ng data. Isipin ang isang marketing analyst na nagpe-paste ng listahan ng mga high-value na lead, na kumpleto sa impormasyon sa pakikipag-ugnayan, sa isang pampublikong tool ng GenAI upang mag-draft ng mga personalized na outreach na email. Sa sandaling iyon, na-exfiltrate ang sensitibong data ng customer at bahagi na ngayon ng data ng pagsasanay ng LLM, sa labas ng kontrol ng iyong organisasyon at sa potensyal na paglabag sa mga regulasyon sa proteksyon ng data tulad ng GDPR o CCPA.

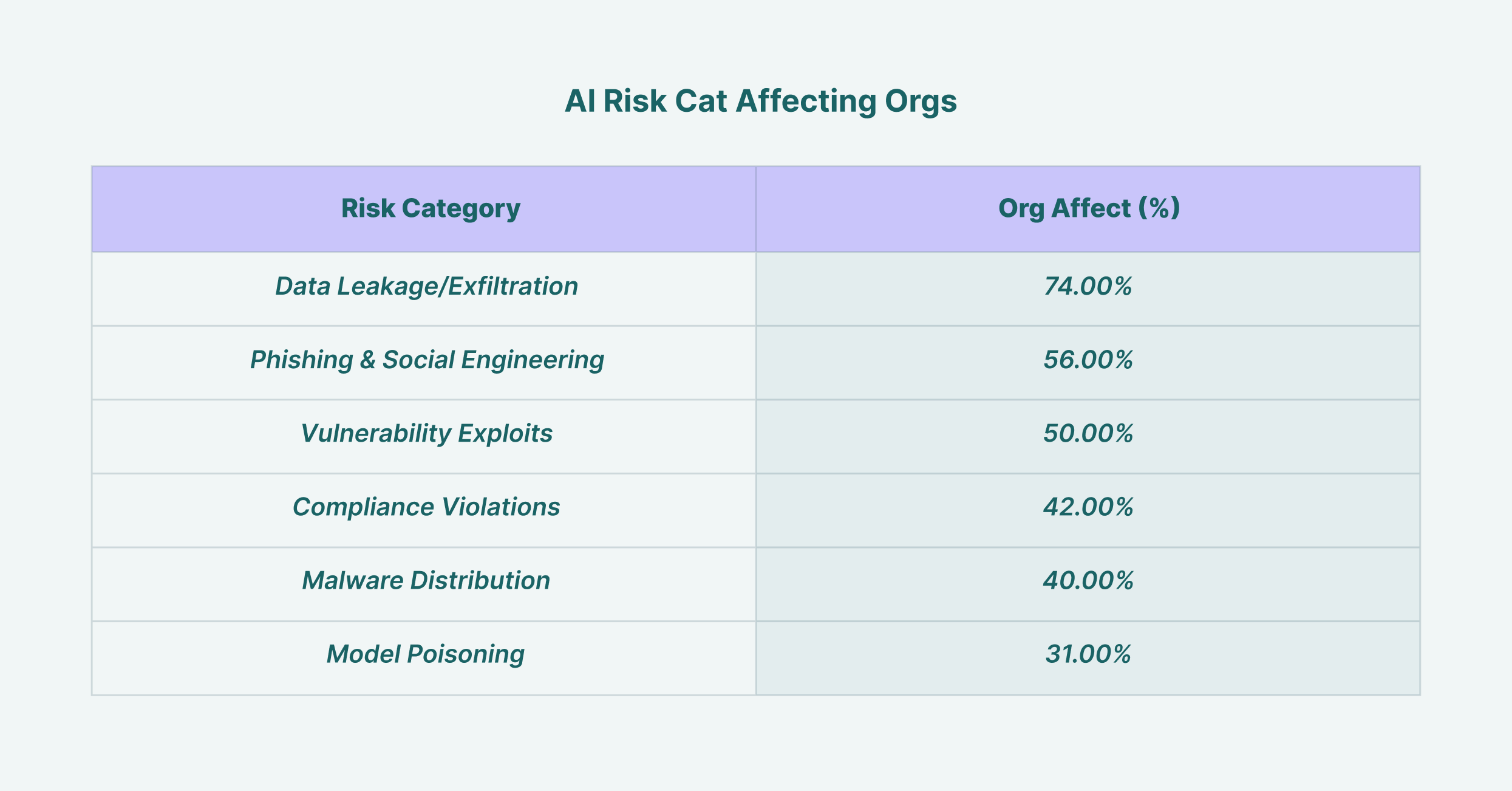

Ang pagtagas ng data ay nakakaapekto sa 74% ng mga organisasyon, na ginagawa itong pinakakaraniwang panganib sa seguridad ng AI, na sinusundan ng mga pag-atake ng phishing sa 56%

Higit pa sa pagtagas ng data, ang mga pinuno ng seguridad ay dapat makipaglaban sa mas advanced na mga banta. Nangyayari ang pagkalason sa modelo kapag sinasadya ng isang attacker ang isang modelo ng malisyosong data sa yugto ng pagsasanay nito, na nagiging sanhi upang makagawa ito ng mga bias, hindi tama, o nakakapinsalang mga output. Ang mga pag-atake sa pag-iwas ay kinabibilangan ng paggawa ng mga input na partikular na idinisenyo upang i-bypass ang mga filter ng seguridad ng AI system. Para sa mga CISO, ang epektibong paggamit ng AI sa pamamahala ng peligro ay nangangahulugan din ng paggamit ng mga tool sa seguridad na pinapagana ng AI upang matukoy ang mga banta na ito. Maaaring suriin ng mga advanced na system sa pagtukoy ng pagbabanta ang pag-uugali ng user at mga daloy ng data upang matukoy ang mga maanomalyang aktibidad na nagpapahiwatig ng insidente sa seguridad na nauugnay sa AI, na ginagawang bahagi ng solusyon ang teknolohiya mula sa pinagmulan ng panganib.

Ang Kritikal na Papel ng isang Patakaran sa Seguridad ng AI

Upang isalin ang iyong balangkas sa malinaw na mga direktiba para sa iyong mga empleyado, ang isang nakatuong patakaran sa seguridad ng AI ay hindi mapag-usapan. Ang dokumentong ito ay nagsisilbing authoritative source sa katanggap-tanggap na paggamit ng AI sa loob ng organisasyon. Dapat itong maging malinaw, maigsi, at madaling ma-access ng lahat ng empleyado, na hindi nag-iiwan ng lugar para sa kalabuan. Ang isang mahusay na ginawang patakaran sa seguridad ng AI ay lumalampas sa simpleng "mga dapat gawin at hindi dapat gawin" at nagbibigay ng konteksto, na nagpapaliwanag bakit ang ilang mga paghihigpit ay inilalagay upang pagyamanin ang isang kultura ng kamalayan sa seguridad sa halip na pagsunod lamang.

Dapat tahasang tukuyin ng patakaran ang ilang mahahalagang bahagi. Una, dapat nitong ilista ang lahat ng sanctioned at aprubadong AI tool, kasama ang proseso para sa paghiling ng pagsusuri ng isang bagong tool. Pinipigilan nito ang paglaganap ng shadow AI. Pangalawa, dapat itong magtatag ng malinaw na mga alituntunin sa paghawak ng data, na tumutukoy kung anong mga uri ng impormasyon ng kumpanya (hal., pampubliko, panloob, kumpidensyal, pinaghihigpitan) ang maaaring gamitin sa kung aling kategorya ng mga tool ng AI. Halimbawa, maaaring katanggap-tanggap ang paggamit ng pampublikong tool ng GenAI para sa pagbubuod ng mga artikulo ng balitang available sa publiko, ngunit mahigpit na ipinagbabawal ang paggamit nito upang pag-aralan ang mga kumpidensyal na projection sa pananalapi. Dapat ding balangkasin ng patakaran ang mga responsibilidad ng user, mga kahihinatnan para sa hindi pagsunod, at ang protocol ng pagtugon sa insidente para sa mga pinaghihinalaang paglabag na nauugnay sa AI, na tinitiyak na nauunawaan ng lahat ang kanilang tungkulin sa pagprotekta sa organisasyon.

Pagsusuri ng Mga Modelo at Plugin: Isang Pagtuon sa AI Third-Party Risk Management

Ang modernong AI ecosystem ay binuo sa isang kumplikadong supply chain ng mga modelo, platform, at plugin na binuo ng mga third party. Ginagawa ng katotohanang ito ang pamamahala ng panganib ng ikatlong partido ng AI bilang isang kritikal na haligi ng iyong pangkalahatang diskarte sa seguridad. Sa tuwing mag-e-enable ang isang empleyado ng bagong plugin para sa kanilang AI assistant o ang iyong development team ay nagsasama ng isang third-party na API, pinapalawak nila ang attack surface ng iyong organisasyon. Ang bawat isa sa mga panlabas na bahaging ito ay nagdadala ng sarili nitong hanay ng mga potensyal na kahinaan, mga patakaran sa privacy ng data, at mga postura ng seguridad, na minana na ngayon ng iyong organisasyon.

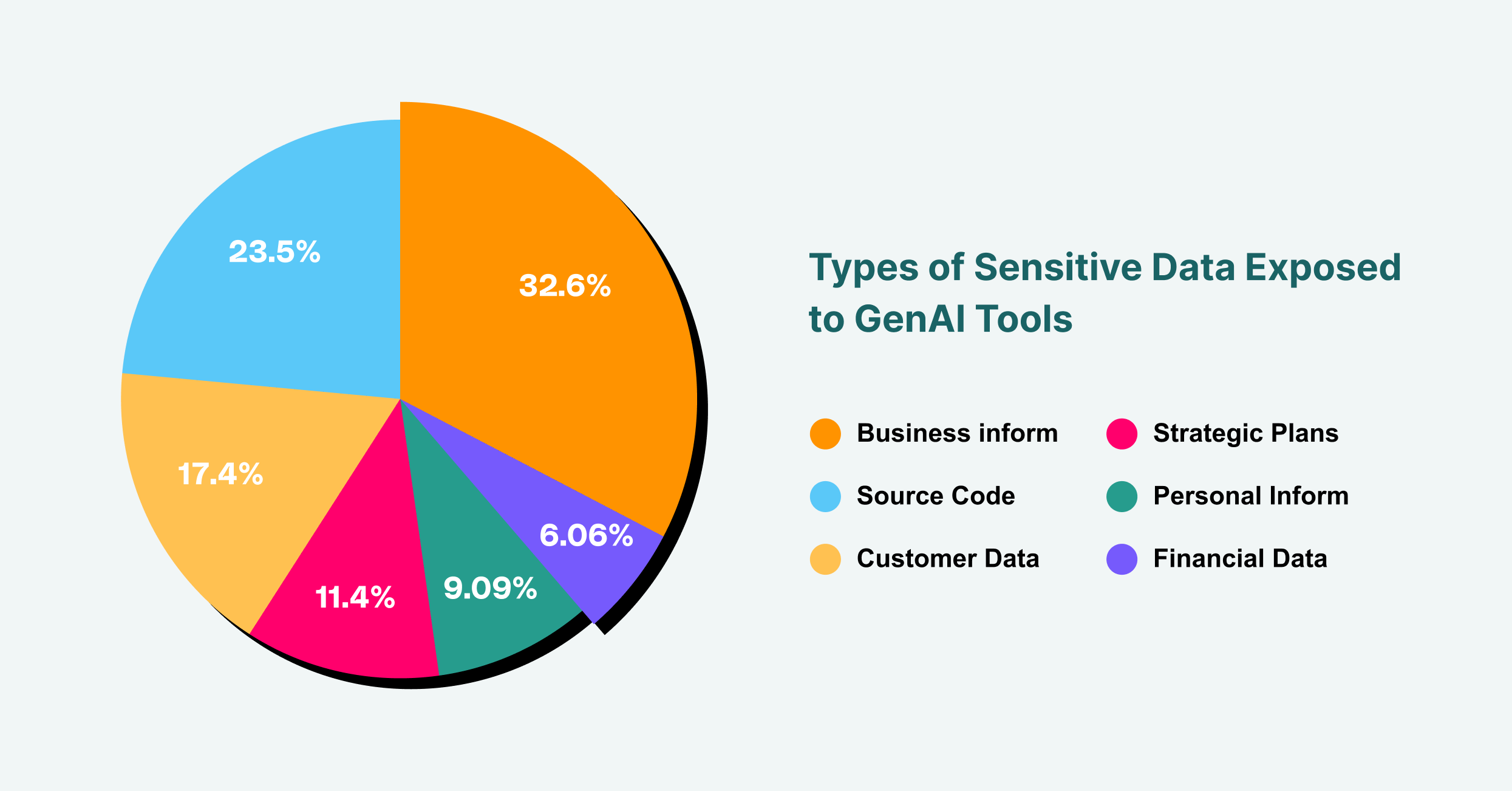

Ang impormasyon ng negosyo ay bumubuo ng 43% ng mga sensitibong data exposure sa GenAI, na sinusundan ng source code sa 31% at data ng customer sa 23%

Samakatuwid, ang isang mahigpit na proseso ng pagsusuri ay mahalaga. Bago ang anumang third-party na tool o component ng AI ay maaprubahan para sa paggamit, dapat itong sumailalim sa isang masusing pagsusuri sa seguridad at privacy. Kabilang dito ang pagsisiyasat sa mga sertipikasyon ng seguridad ng vendor, mga kasanayan sa pangangasiwa ng data, at mga kakayahan sa pagtugon sa insidente. Anong data ang kinokolekta ng tool? Saan ito nakaimbak, at sino ang may access dito? Ang vendor ba ay may kasaysayan ng mga paglabag sa seguridad? Para sa mga plugin ng AI, na isang lumalagong vector para sa mga pag-atake na nakabatay sa browser, ang proseso ng pag-vetting ay dapat na mas mahigpit. Kasama sa mga itatanong ang: Anong mga pahintulot ang kailangan ng plugin? Sino ang developer? Na-audit na ba ang code nito? Sa pamamagitan ng pagtrato sa bawat third-party na serbisyo ng AI na may parehong antas ng pagsisiyasat gaya ng anumang iba pang kritikal na vendor, maaari mong pagaanin ang panganib ng pag-atake ng supply chain na makompromiso ang iyong organisasyon.

Pagpapatupad ng AI Risk Management Tools

Ang patakaran at proseso ay batayan, ngunit hindi sapat ang mga ito nang walang teknikal na pagpapatupad. Dito nagiging mahalaga ang mga tool sa pamamahala ng peligro ng AI. Ang mga solusyong ito ay nagbibigay ng kakayahang makita at kontrol na kinakailangan upang matiyak na ang iyong patakaran sa seguridad ng AI ay sinusunod sa pagsasanay, hindi lamang sa teorya. Dahil ang pangunahing interface para sa karamihan ng mga user na nakikipag-ugnayan sa GenAI ay ang web browser, ang mga tool na maaaring gumana sa layer na ito ay natatanging nakaposisyon upang magbigay ng epektibong pangangasiwa.

Ang mga extension o platform ng browser ng enterprise, tulad ng LayerX, ay nag-aalok ng makapangyarihang mekanismo para sa pamamahala ng panganib ng AI. Maaari nilang matuklasan at maimapa ang lahat ng paggamit ng GenAI sa buong organisasyon, na nagbibigay ng real-time na imbentaryo kung saan ina-access ng mga user kung aling mga platform. Ang visibility na ito ay ang unang hakbang sa pag-shut down ng shadow AI. Mula doon, maaaring ipatupad ng mga tool na ito ang mga butil-butil, nakabatay sa panganib na mga guardrail. Halimbawa, maaari kang mag-configure ng patakaran na pumipigil sa mga user na mag-paste ng text na tinukoy bilang "kumpidensyal" sa isang pampublikong AI chatbot, o nagbabala sa mga user bago sila mag-upload ng sensitibong dokumento. Sinusubaybayan at kinokontrol ng layer ng proteksyon na ito ang daloy ng data sa pagitan ng browser ng user at ng web, na epektibong kumikilos bilang isang Data Loss Prevention (DLP) na solusyon na partikular na iniakma para sa edad ng AI. Ang mga tamang tool sa pamamahala ng peligro ng AI ay tumutulay sa agwat sa pagitan ng patakaran at katotohanan, na nagbibigay ng mga teknikal na paraan upang ipatupad ang iyong mga desisyon sa pamamahala.

Paghawak at Pagtugon sa Insidente sa Edad ng AI

Kahit na may pinakamahusay na mga hakbang sa pag-iwas, maaari pa ring mangyari ang mga insidente. Ang pagtugon ng iyong organisasyon ay isang tiyak na salik sa pagliit ng epekto ng isang paglabag. Ang isang epektibong plano sa pagtugon sa insidente para sa AI ay dapat na parehong partikular at mahusay na nasanay. Kapag na-trigger ang isang alerto, mula man sa isang ulat ng user o isang awtomatikong pag-detect ng isa sa iyong mga tool sa seguridad, ang pangkat ng pagtugon ay nangangailangan ng isang malinaw na playbook upang sundin.

Ang unang hakbang ay ang pagpigil. Kung ang isang user ay hindi sinasadyang nag-leak ng sensitibong data sa isang LLM, ang agarang priyoridad ay bawiin ang access at maiwasan ang karagdagang pagkakalantad. Maaaring kabilang dito ang pansamantalang hindi pagpapagana ng access ng user sa tool o kahit na paghiwalayin ang kanilang makina mula sa network. Ang susunod na yugto ay pagsisiyasat. Anong data ang na-leak? Sino ang responsable? Paano nabigo ang aming mga kontrol? Ang forensic analysis na ito ay mahalaga para sa pag-unawa sa ugat na sanhi at pagpigil sa pag-ulit. Panghuli, dapat tugunan ng plano ang pagtanggal at pagbawi, na kinabibilangan ng pag-abiso sa mga apektadong partido ayon sa kinakailangan ng batas, paggawa ng mga hakbang upang alisin ang data ng AI vendor kung maaari, at pag-update ng mga patakaran at kontrol sa seguridad batay sa mga natutunan. Ang isang mature na AI at postura sa pamamahala sa peligro ay nangangahulugan ng pagiging handa na tumugon sa isang insidente tulad ng kailangan mong maiwasan ang isa.

Pagsubaybay at Pagpapahusay ng Iyong Posture sa Panganib sa AI

Ang pamamahala sa panganib ng AI ay hindi isang beses na proyekto; ito ay isang tuluy-tuloy na ikot ng pagtatasa, pagpapagaan, at pagpapabuti. Ang tanawin ng pagbabanta ay dynamic, na may mga bagong AI tool at attack vectors na patuloy na umuusbong. Samakatuwid, ang pagsubaybay sa postura ng panganib sa AI ng iyong organisasyon sa paglipas ng panahon ay mahalaga para matiyak na mananatiling epektibo ang iyong mga panlaban. Nangangailangan ito ng pangako sa patuloy na pagsubaybay at paggamit ng mga sukatan upang mabilang ang iyong antas ng panganib at ang pagganap ng iyong mga kontrol.

Maaaring kabilang sa Key Performance Indicators (KPIs) ang bilang ng mga hindi sinanksiyong AI tool na natukoy, ang dami ng mga insidente ng pagtagas ng data na napigilan, at ang porsyento ng mga empleyadong nakakumpleto ng AI security training. Ang mga regular na pag-audit at pagsubok sa pagtagos, partikular na nakatuon sa mga AI system, ay maaari ding magbigay ng napakahalagang mga insight sa mga kahinaan sa iyong mga panlaban. Sa pamamagitan ng patuloy na pagsukat at pagpino sa iyong diskarte, lumikha ka ng isang nababanat na programa sa seguridad na umaangkop sa mga umuusbong na hamon ng mundong hinimok ng AI. Tinitiyak ng proactive na paninindigan na ito na patuloy na magagamit ng iyong organisasyon ang kapangyarihan ng AI nang may kumpiyansa at secure na paraan, na ginagawang isang mahusay na pinamamahalaang madiskarteng kalamangan ang isang potensyal na mapagkukunan ng sakuna.