Integracija generativne umjetne inteligencije u poslovne tijekove rada nije stvar budućnosti; događa se upravo sada, tempom koji često nadmašuje sigurnosne i upravljačke mogućnosti. Za svaku dokumentiranu, sankcioniranu upotrebu AI alata koji povećava produktivnost, postoje bezbrojni slučajevi „sjene“ upotrebe, izlažući organizacije značajnim prijetnjama. Izazov za sigurnosne analitičare, CISO-e i IT lidere je jasan: kako omogućiti inovacije koje AI obećava bez izazivanja neprihvatljivih rizika? Odgovor leži u discipliniranom, proaktivnom pristupu upravljanju rizicima umjetne inteligencije. Ovdje se ne radi o blokiranju napretka; radi se o izgradnji zaštitnih ograda koje omogućuju vašoj organizaciji sigurno ubrzanje.

Rastuća potreba za upravljanjem umjetnom inteligencijom

Prije nego što se može provesti bilo kakva učinkovita strategija upravljanja rizikom, moraju se uspostaviti temelji upravljanja umjetnom inteligencijom. Brzo, decentralizirano usvajanje alata umjetne inteligencije znači da bez formalne strukture upravljanja organizacije djeluju u mraku. Zaposlenici, željni poboljšanja svoje učinkovitosti, samostalno će usvajati različite platforme i dodatke umjetne inteligencije, često bez razmatranja sigurnosnih implikacija. To stvara složenu mrežu nesankcioniranog korištenja SaaS-a, gdje osjetljivi korporativni podaci, od osobnih podataka i financijskih zapisa do intelektualnog vlasništva, mogu nenamjerno biti preneseni na velike jezične modele (LLM) trećih strana.

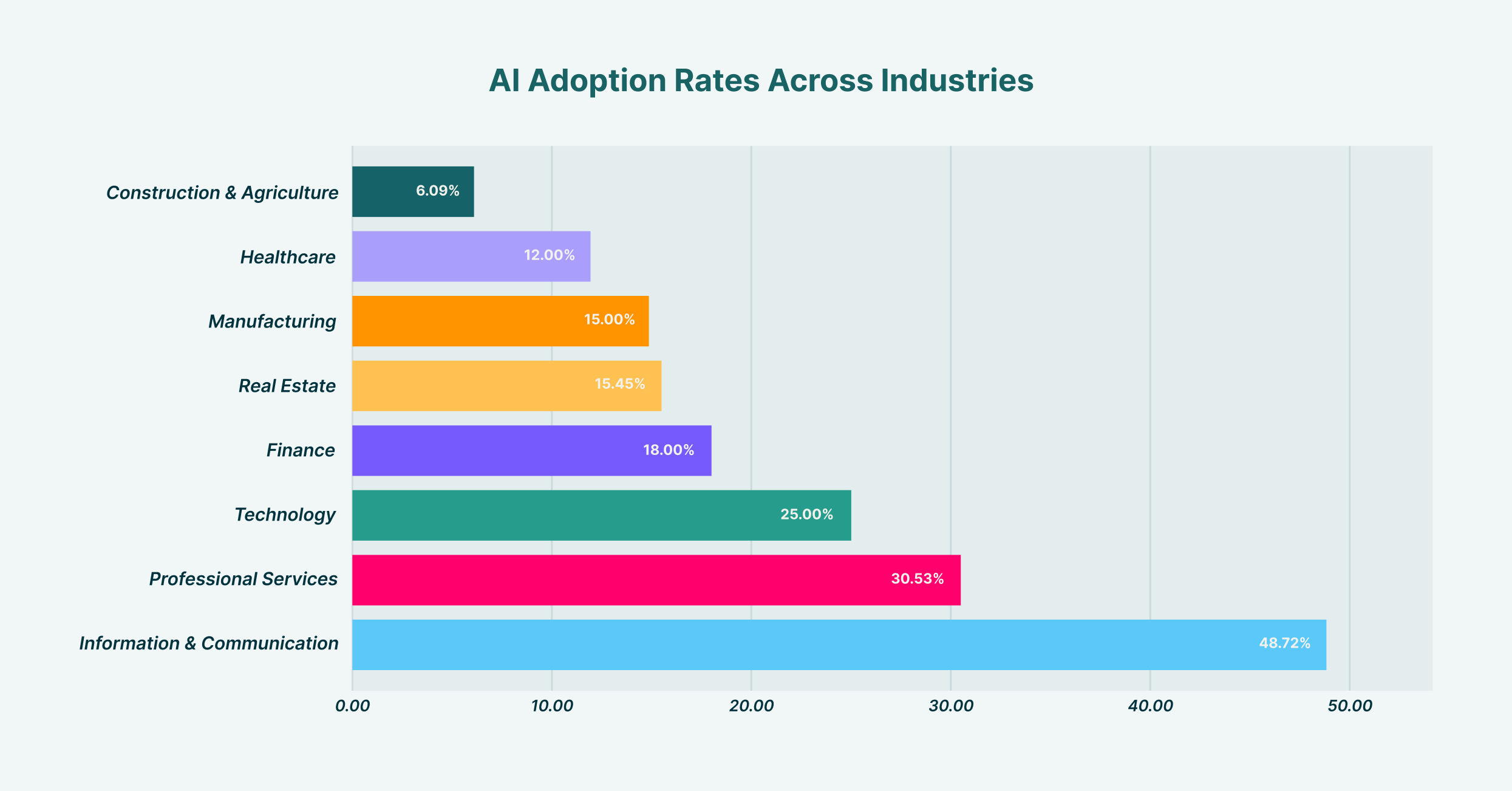

Prihvaćanje umjetne inteligencije značajno varira među industrijama, pri čemu informacijska i komunikacijska industrija prednjači s 48.7%, a građevinarstvo i poljoprivreda imaju najniži postotak sa 6.1%.

Uspostavljanje robusnog upravljanja umjetnom inteligencijom uključuje stvaranje međufunkcionalnog tima, koji obično uključuje predstavnike IT, sigurnosnog, pravnog i poslovnog odjela. Ovaj odbor zadužen je za definiranje stava organizacije o umjetnoj inteligenciji. Kakav je naš apetit prema riziku? Koji se slučajevi upotrebe potiču, a koji su zabranjeni? Tko je odgovoran kada se dogodi incident povezan s umjetnom inteligencijom? Odgovori na ova pitanja pružaju jasnoću potrebnu za izgradnju politika i kontrola. Bez ovog strateškog smjera od vrha prema dolje, svaki pokušaj upravljanja rizikom postaje niz nepovezanih, reaktivnih mjera, a ne kohezivna obrana. Ovaj okvir upravljanja postaje nacrt za sve sljedeće sigurnosne napore, osiguravajući da su tehnologija, politika i ponašanje korisnika usklađeni.

Izgradnja okvira za upravljanje rizicima umjetne inteligencije

S uspostavljenom strukturom upravljanja, sljedeći korak je izgradnja formalnog okvira za upravljanje rizicima umjetne inteligencije. Ovaj okvir operacionalizira vaša načela upravljanja, pretvarajući strategiju visoke razine u konkretne, ponovljive procese. Pruža strukturiranu metodu za identificiranje, procjenu, ublažavanje i praćenje rizika povezanih s umjetnom inteligencijom u cijeloj organizaciji. Umjesto ponovnog izmišljanja kotača, organizacije mogu prilagoditi utvrđene modele, poput NIST-ovog okvira za upravljanje rizicima umjetne inteligencije, kako bi odgovarali njihovom specifičnom operativnom kontekstu i krajoliku prijetnji.

Razvoj učinkovitog okvira za upravljanje rizicima umjetne inteligencije trebao bi biti metodičan proces. Počinje stvaranjem sveobuhvatnog popisa svih sustava umjetne inteligencije koji su u upotrebi; i odobrenih i neodobrenih. Ova početna faza otkrivanja je ključna; ne možete zaštititi ono što ne možete vidjeti. Nakon otkrivanja, okvir bi trebao ocrtati postupke za procjenu rizika, dodjeljivanje bodova na temelju čimbenika poput vrste podataka koji se obrađuju, mogućnosti modela i njegove integracije s drugim kritičnim sustavima. Strategije ublažavanja zatim se osmišljavaju na temelju ove procjene, od tehničkih kontrola i obuke korisnika do potpune zabrane visokorizičnih aplikacija. Konačno, okvir mora uključivati ritam za kontinuirano praćenje i pregled, jer će se i ekosustav umjetne inteligencije i njegova upotreba u vašoj organizaciji stalno razvijati. Postoje različiti okviri za upravljanje rizicima umjetne inteligencije, ali najuspješniji su oni koji nisu statični dokumenti, već žive, dišuće komponente sigurnosnog programa organizacije.

Kategorizacija rizika umjetne inteligencije: od krađe podataka do trovanja modela

Ključna komponenta umjetne inteligencije i upravljanja rizicima je razumijevanje specifičnih vrsta prijetnji s kojima se suočavate. Rizici nisu monolitni; obuhvaćaju spektar od kršenja privatnosti podataka do sofisticiranih napada na same AI modele. Jedna od najneposrednijih i najčešćih prijetnji je curenje podataka. Zamislite marketinškog analitičara koji lijepi popis visokovrijednih potencijalnih klijenata, zajedno s kontaktnim podacima, u javni GenAI alat za izradu personaliziranih e-poruka za informiranje. U tom trenutku, osjetljivi podaci o kupcima su ukradeni i sada su dio podataka za obuku LLM-a, izvan kontrole vaše organizacije i potencijalno krše propise o zaštiti podataka poput GDPR-a ili CCPA-a.

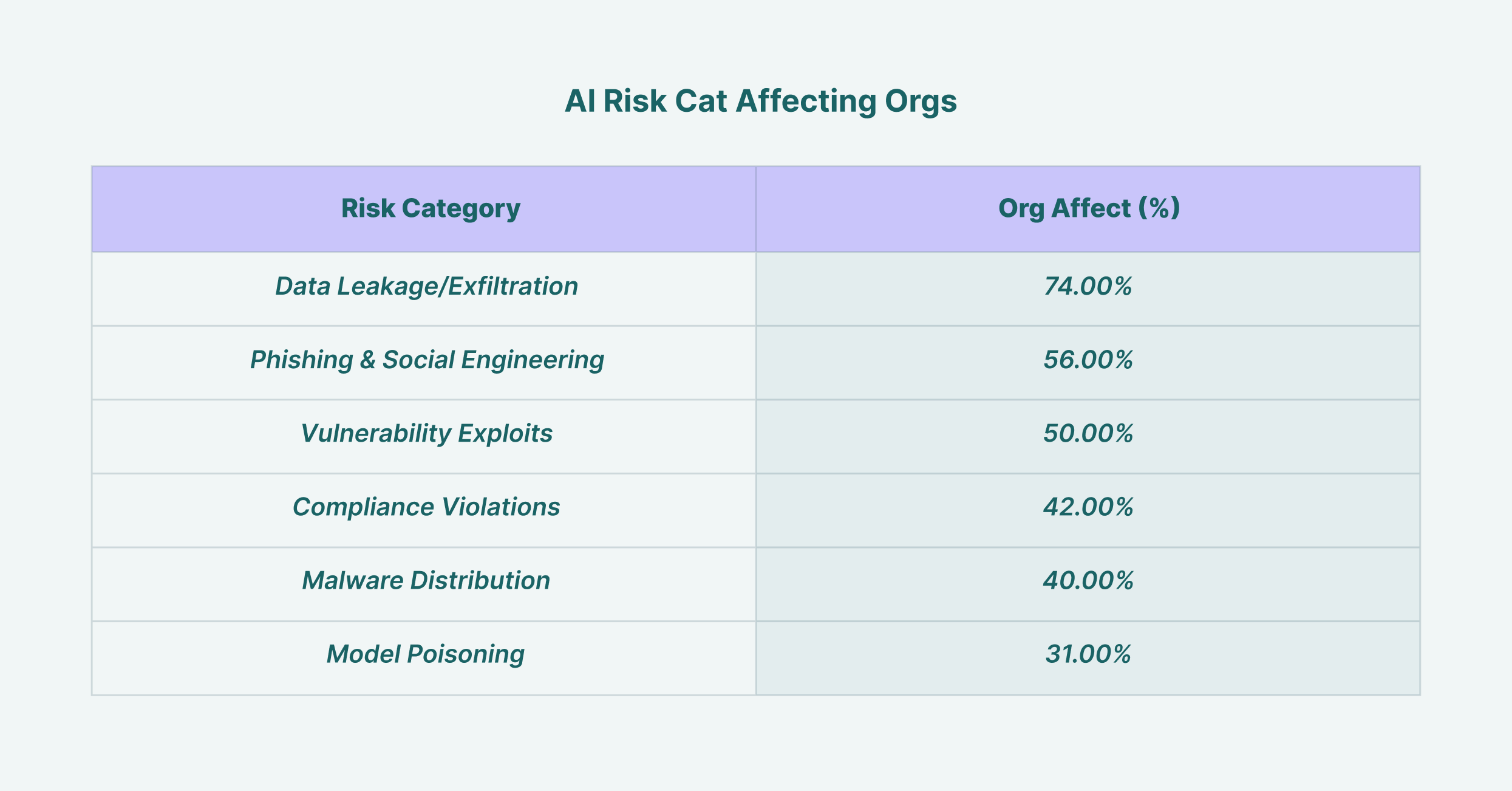

Curenje podataka utječe na 74% organizacija, što ga čini najčešćim sigurnosnim rizikom umjetne inteligencije, a slijede ga phishing napadi s 56%.

Osim curenja podataka, sigurnosni lideri moraju se suočiti s naprednijim prijetnjama. Trovanje modela događa se kada napadač namjerno unosi zlonamjerne podatke u model tijekom faze obuke, uzrokujući da proizvodi pristrane, netočne ili štetne izlaze. Napadi izbjegavanja uključuju izradu ulaza koji su posebno dizajnirani za zaobilaženje sigurnosnih filtera AI sustava. Za CISO-e, učinkovita upotreba AI u upravljanju rizicima također znači korištenje sigurnosnih alata pokretanih AI-jem za otkrivanje upravo tih prijetnji. Napredni sustavi za otkrivanje prijetnji mogu analizirati ponašanje korisnika i tokove podataka kako bi identificirali anomalne aktivnosti koje ukazuju na sigurnosni incident povezan s AI-jem, pretvarajući tehnologiju iz izvora rizika u komponentu rješenja.

Ključna uloga sigurnosne politike umjetne inteligencije

Kako biste svoj okvir preveli u jasne smjernice za svoje zaposlenike, posebna politika sigurnosti umjetne inteligencije nije predmet pregovora. Ovaj dokument služi kao autoritativni izvor o prihvatljivoj upotrebi umjetne inteligencije unutar organizacije. Trebao bi biti jasan, sažet i lako dostupan svim zaposlenicima, ne ostavljajući prostora za dvosmislenost. Dobro osmišljena politika sigurnosti umjetne inteligencije nadilazi jednostavna „što treba, a što ne treba raditi“ i pruža kontekst, objašnjavajući zašto određena ograničenja postoje kako bi se potaknula kultura sigurnosne svijesti, a ne samo pridržavanje propisa.

Politika mora eksplicitno definirati nekoliko ključnih područja. Prvo, trebala bi navesti sve sankcionirane i odobrene alate umjetne inteligencije, zajedno s postupkom za zahtjev za evaluaciju novog alata. To sprječava širenje shadow AI-a. Drugo, morala bi uspostaviti jasne smjernice za rukovanje podacima, specificirajući koje se vrste korporativnih informacija (npr. javne, interne, povjerljive, ograničene) mogu koristiti s kojom kategorijom alata umjetne inteligencije. Na primjer, korištenje javnog GenAI alata za sažimanje javno dostupnih novinskih članaka moglo bi biti prihvatljivo, ali njegovo korištenje za analizu povjerljivih financijskih projekcija bilo bi strogo zabranjeno. Politika bi također trebala ocrtati odgovornosti korisnika, posljedice nepoštivanja i protokol odgovora na incidente za sumnjive povrede povezane s umjetnom inteligencijom, osiguravajući da svi razumiju svoju ulogu u zaštiti organizacije.

Evaluacija modela i dodataka: Fokus na upravljanje rizicima treće strane u vezi s umjetnom inteligencijom

Moderni ekosustav umjetne inteligencije izgrađen je na složenom lancu opskrbe modela, platformi i dodataka koje su razvile treće strane. Ova stvarnost čini upravljanje rizicima umjetne inteligencije trećih strana ključnim stupom vaše ukupne sigurnosne strategije. Svaki put kada zaposlenik omogući novi dodatak za svog AI asistenta ili vaš razvojni tim integrira API treće strane, proširuje površinu napada vaše organizacije. Svaka od ovih vanjskih komponenti nosi vlastiti skup potencijalnih ranjivosti, pravila o privatnosti podataka i sigurnosnih postavki, koje sada nasljeđuje vaša organizacija.

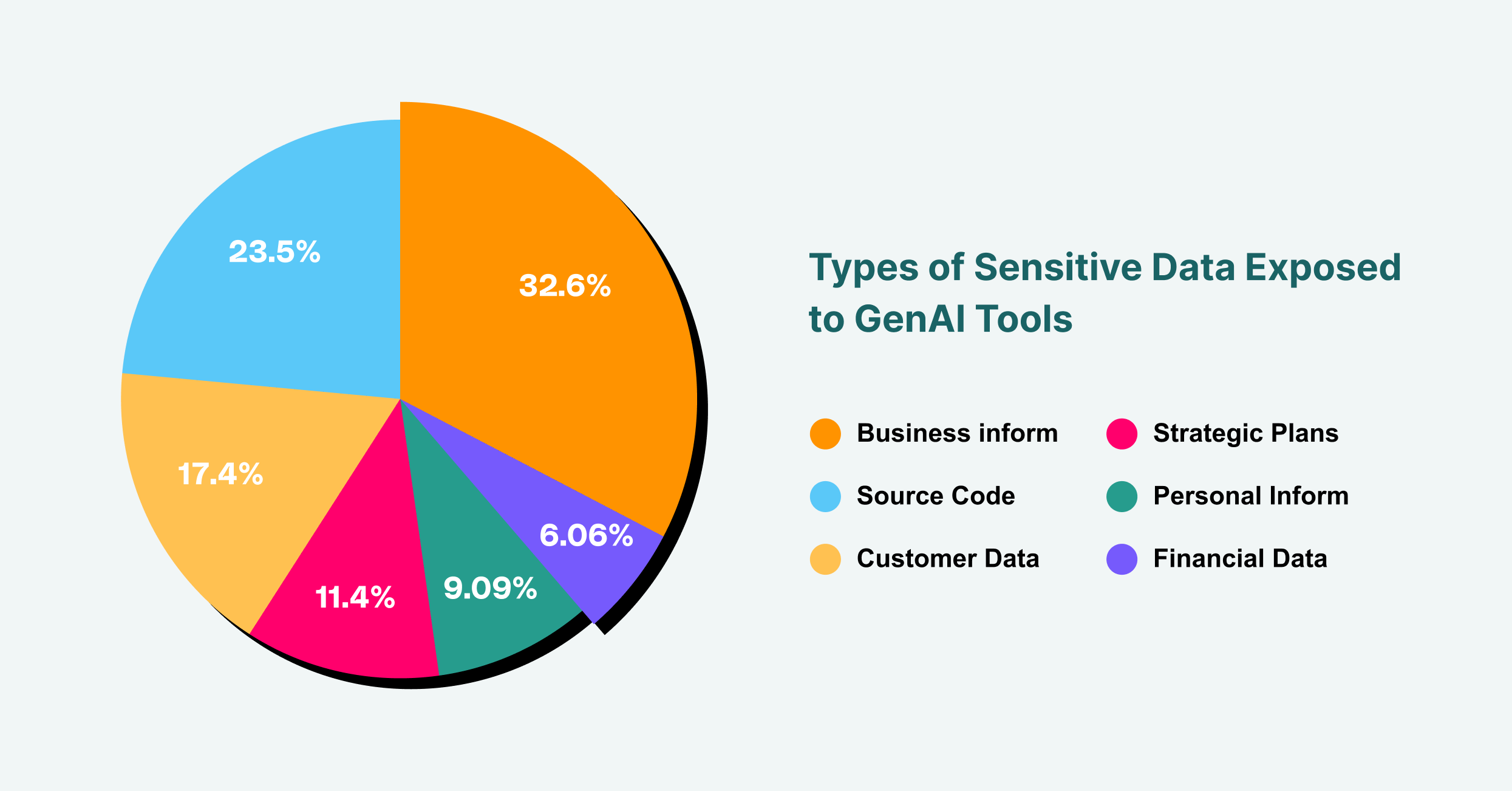

Poslovne informacije čine 43% izloženosti osjetljivih podataka GenAI-u, slijede izvorni kod s 31% i podaci o korisnicima s 23%.

Stoga je rigorozan proces evaluacije ključan. Prije nego što se bilo koji alat ili komponenta umjetne inteligencije treće strane odobri za upotrebu, mora se podvrgnuti temeljitom pregledu sigurnosti i privatnosti. To uključuje ispitivanje sigurnosnih certifikata dobavljača, praksi rukovanja podacima i mogućnosti odgovora na incidente. Koje podatke alat prikuplja? Gdje se pohranjuju i tko im ima pristup? Ima li dobavljač povijest sigurnosnih kršenja? Za AI dodatke, koji su sve veći vektor za napade temeljene na pregledniku, proces provjere trebao bi biti još stroži. Pitanja koja treba postaviti uključuju: Koje dozvole su potrebne dodatku? Tko je programer? Je li njegov kod revidiran? Tretiranjem svake AI usluge treće strane s istom razinom kontrole kao i bilo kojeg drugog ključnog dobavljača, možete ublažiti rizik od napada na lanac opskrbe koji ugrožava vašu organizaciju.

Implementacija alata za upravljanje rizicima umjetne inteligencije

Politika i proces su temeljni, ali nisu dovoljni bez tehničke provedbe. Tu alati za upravljanje rizicima umjetne inteligencije postaju ključni. Ova rješenja pružaju vidljivost i kontrolu potrebnu kako bi se osiguralo da se vaša politika sigurnosti umjetne inteligencije primjenjuje u praksi, a ne samo u teoriji. S obzirom na to da je primarno sučelje za većinu korisnika koji komuniciraju s GenAI-jem web preglednik, alati koji mogu raditi na ovom sloju jedinstveno su pozicionirani za pružanje učinkovitog nadzora.

Proširenja ili platforme za poslovne preglednike, poput LayerX-a, nude snažan mehanizam za upravljanje rizicima umjetne inteligencije. Mogu otkriti i mapirati svu upotrebu GenAI-a u cijeloj organizaciji, pružajući popis korisnika koji pristupaju kojim platformama u stvarnom vremenu. Ova vidljivost je prvi korak u isključivanju umjetne inteligencije u sjeni. Nakon toga, ovi alati mogu provesti detaljne zaštitne mjere temeljene na riziku. Na primjer, mogli biste konfigurirati pravilo koje sprječava korisnike da lijepe tekst označen kao "povjerljiv" u javnog AI chatbota ili koje upozorava korisnike prije nego što prenesu osjetljivi dokument. Ovaj sloj zaštite prati i kontrolira protok podataka između korisnikovog preglednika i weba, učinkovito djelujući kao rješenje za sprječavanje gubitka podataka (DLP) posebno prilagođeno za doba umjetne inteligencije. Pravi alati za upravljanje rizicima umjetne inteligencije premošćuju jaz između pravila i stvarnosti, pružajući tehnička sredstva za provođenje vaših upravljačkih odluka.

Rješavanje incidenata i odgovor na njih u doba umjetne inteligencije

Čak i uz najbolje preventivne mjere, incidenti se i dalje mogu dogoditi. Način na koji vaša organizacija reagira ključan je faktor u minimiziranju utjecaja kršenja sigurnosti. Učinkovit plan odgovora na incidente za umjetnu inteligenciju mora biti i specifičan i dobro uvježban. Kada se aktivira upozorenje, bilo da je to korisnička prijava ili automatizirana detekcija putem jednog od vaših sigurnosnih alata, tim za odgovor treba jasan priručnik kojeg se treba pridržavati.

Prvi korak je obuzdavanje. Ako je korisnik nenamjerno procurio osjetljive podatke na LLM, neposredni prioritet je opozvati pristup i spriječiti daljnje izlaganje. To bi moglo uključivati privremeno onemogućavanje korisnikovog pristupa alatu ili čak izolaciju njihovog računala od mreže. Sljedeća faza je istraga. Koji su podaci procurili? Tko je bio odgovoran? Kako su naše kontrole zakazale? Ova forenzička analiza ključna je za razumijevanje uzroka i sprječavanje ponavljanja. Konačno, plan mora obuhvatiti iskorjenjivanje i oporavak, što uključuje obavještavanje pogođenih strana kako je propisano zakonom, poduzimanje koraka da dobavljač umjetne inteligencije ukloni podatke ako je moguće i ažuriranje sigurnosnih politika i kontrola na temelju naučenih lekcija. Zreo stav prema umjetnoj inteligenciji i upravljanju rizicima znači biti jednako spreman reagirati na incident kao i spriječiti ga.

Praćenje i poboljšanje vašeg stava prema riziku umjetne inteligencije

Upravljanje rizicima umjetne inteligencije nije jednokratni projekt; to je kontinuirani ciklus procjene, ublažavanja i poboljšanja. Krajolik prijetnji je dinamičan, s novim alatima umjetne inteligencije i vektorima napada koji se stalno pojavljuju. Stoga je praćenje stanja rizika umjetne inteligencije u vašoj organizaciji tijekom vremena ključno za osiguranje učinkovitosti vaše obrane. To zahtijeva predanost kontinuiranom praćenju i korištenju metrike za kvantificiranje razine rizika i učinkovitosti vaših kontrola.

Ključni pokazatelji uspješnosti (KPI) mogu uključivati broj otkrivenih neodobrenih alata umjetne inteligencije, količinu spriječenih incidenata curenja podataka i postotak zaposlenika koji su završili obuku o sigurnosti umjetne inteligencije. Redovite revizije i testiranje penetracije, posebno usmjereni na sustave umjetne inteligencije, također mogu pružiti neprocjenjive uvide u slabosti vaše obrane. Kontinuiranim mjerenjem i usavršavanjem vašeg pristupa stvarate otporan sigurnosni program koji se prilagođava promjenjivim izazovima svijeta vođenog umjetnom inteligencijom. Ovaj proaktivni stav osigurava da vaša organizacija može nastaviti s pouzdanjem i sigurnošću koristiti snagu umjetne inteligencije, pretvarajući potencijalni izvor katastrofalnog rizika u dobro upravljanu stratešku prednost.